LA EVALUACIÓN DE POLÍTICAS PÚBLICAS. UNA ASIGNATURA PENDIENTE DE LA ADMINISTRACIÓN

PUBLIC POLICY ASSESSMENT: AN ADMINISTRATION PENDING SUBJECT

Revista Colegiada de Ciencia, vol.. 1, núm. 1, 2019

Universidad de Panamá

Recepción: 12 Agosto 2019

Aprobación: 15 Septiembre 2019

Resumen: Los sistemas de evaluación surgieron hace años en el ámbito empresarial dentro del sector privado. Hoy, el sector público también se ve ante la necesidad de aplicar estos sistemas para alcanzar mayores niveles de eficacia y eficiencia en la gestión y aplicación de unos recursos financieros cada vez más restringidos para no incurrir en elevados niveles de déficit público. A ello habría que añadir la creciente demanda de información por parte de los ciudadanos, que exigen una mayor capacidad de control sobre aquéllos que tienen la responsabilidad de gobernar y de gestionar el dinero público. Las razones que determinan la distribución de estos recursos, así como el éxito o fracaso de las diferentes intervenciones que se pongan en marcha, deben ser explicadas y justificadas. La evaluación debe proporcionar dicha información en un ejercicio de transparencia (rendición de cuentas) y gobernanza. Inicialmente, la evaluación estuvo centrada en los mecanismos de programación, implantación y ejecución de los proyectos y programas, prestándose poca atención al impacto de las actuaciones públicas financiadas con cargo a los presupuestos del Estado. Sin embargo, en los últimos años, se han realizado grandes esfuerzos desde algunos organismos internacionales (Banco Mundial, Comisión Económica para América Latina y el Caribe, Comisión Europea...) para impulsar la evaluación de impacto de las intervenciones públicas; esto es, establecer un vínculo causal entre la política pública que se evalúa y los efectos observados por el evaluador. Actualmente, este tipo de evaluación ha adquirido un papel relevante en el diseño de programas y políticas públicas y se ha convertido en el enfoque estándar para identificar sus efectos. El objetivo de este artículo es poner de manifiesto las ventajas e inconvenientes que supone la evaluación de políticas públicas, así como las principales cuestiones a resolver en dicho proceso.

Palabras clave: políticas públicas, evaluación, indicadores, transparencia, rendición de cuentas.

Abstract: Evaluation systems emerged years ago in the business field within the private sector. Today, the public sector is also faced with the need to apply these systems to achieve higher levels of effectiveness and efficiency in the management and application of increasingly restricted financial resources so as not to incur high levels of public deficit. To this should be added the growing demand for information from citizens, who demand a greater capacity for control over those who have the responsibility to govern and manage public money. The reasons that determine the distribution of these resources, as well as the success or failure of the different interventions that are put in place, must be explained and justified. The evaluation must provide such information in an exercise of transparency (accountability) and governance. Initially, the evaluation focused on the mechanisms for programming, implementation and execution of projects and programs, with little attention being paid to the impact of public actions financed from the State budgets. However, in recent years, great efforts have been made by some international organizations (World Bank, Economic Commission for Latin America and the Caribbean, European Commission ...) to promote impact evaluations of public interventions; in other words, establish a causal link between the public policy that is evaluated and the effects observed by the evaluator. Currently, this type of evaluation has acquired a relevant role in the design of programs and public policies and has become the standard approach to identify its effects. The objective of this article is to highlight the advantages and disadvantages of the evaluation of public policies, as well as the main issues to be resolved in this process.

Keywords: public policy, assessment, indicators, transparency, accountability.

1. INTRODUCCIÓN: ALGUNAS PRECISIONES CONCEPTUALES

En el proceso de formulación de las políticas públicas se plantean dos cuestiones básicas: (i) cómo contribuir a mejorar su eficacia (efectividad) en la resolución de los problemas económicos y sociales y (ii) cómo lograr una mayor transparencia y participación. Esto no es posible conseguirlo sin integrar los sistemas de evaluación en los procesos de toma de decisiones en materia de políticas públicas. Las dificultades y la complejidad que presenta la fase de evaluación no nos debe hacer olvidar que ésta es imprescindible para clarificar la oportunidad política, la solvencia técnica y los resultados de cualquier intervención pública, ante un nuevo tipo de ciudadano que comienza a ser exigente con los resultados del “producto administrativo” y con la propia administración, la cual debe tener capacidad de respuesta rápida ante las demandas de la sociedad transformándose en una administración más receptiva, más transparente en sus actuaciones y más accesible y cercana al ciudadano (Albi y Onrrubia, 2015). Sin duda, esta nueva forma de entender la acción pública requiere realizar un ejercicio de evaluación.

En los países latinos, el término política tiene varias acepciones. Una de ellas es la que se corresponde con el término polity, en inglés, para referirse al marco normativo, organizativo y a las reglas del juego de la acción política. Constituye lo que podríamos denominar el sistema político-institucional (las instituciones políticas y los órganos constitucionales). Una segunda acepción es la que designa los fenómenos de lucha por el poder, la concurrencia entre partidos, grupos de interés, categorías sociales y personas, para el ejercicio de influencia y la ocupación de funciones de autoridad en una colectividad, en un país, en un mercado electoral o en los procesos de decisión. Política significa aquí lo que en inglés se designa como politics. El tercer uso del término política distingue lo que los anglosajones designan con el término policy, los outputs o productos de la acción de gobierno, que pueden tomar diferentes formas (leyes, reglamentos, programas, proyectos…). Es en este último sentido en el que cabe hablar claramente de política pública; es decir, de los actos y de los “no actos” comprometidos de una autoridad pública frente a un problema en un sector relevante de su competencia, con una serie de elementos que son necesarios: (i) las reglas institucionales (generales y específicas), (ii) los actores (agentes implicados, stakeholders), (iii) los recursos (financieros, humanos, patrimoniales…) y el contenido de la política en cuestión. La evaluación exige prestar atención a todos ellos.

El ciclo de una política pública es un modelo descriptivo que trata de esquematizar el proceso de decisión, de ejecución y de evaluación de las políticas públicas. Se inicia con el surgimiento de un problema o una necesidad colectiva que exige la intervención de los poderes públicos; continúa con su inclusión en la agenda gubernamental, la formulación de alternativas y la implementación de las decisiones adoptadas; y finaliza con la evaluación que aspira a determinar los resultados y los efectos de dicha política en términos de cambios en la conducta de los grupos objetivo y de grado de resolución del problema que la originó.

En consecuencia, la evaluación constituye una de las fases del ciclo de una política pública, de trascendental importancia, pues permite una retroalimentación de información para la mejora de la gestión pública. Parece claro que la evaluación no puede considerarse como un hecho aislado, sino como una cadena de resultados que involucra varias etapas del ciclo de una política pública, desde la fase de planificación en los procesos previos a la decisión y/o la concepción de la acción (evaluación ex-ante o a priori), a la de implementación (evaluación intermedia o a medio plazo) y a la de verificación de los resultados e impactos, identificando los factores de éxito o de fracaso del programa, prestando especial atención al análisis de la sostenibilidad en el tiempo de sus efectos y a la identificación de las mejores prácticas (evaluación ex-post o a posteriori).

El objetivo de este artículo es poner de manifiesto las ventajas e inconvenientes que supone la evaluación de las políticas públicas, así como las principales cuestiones a resolver en dicho proceso, tras más de veinticinco años de experiencia investigadora y profesional como evaluadora en este ámbito, aplicando diferentes técnicas y metodologías. El artículo se estructura en cinco epigrafes. Tras la introducción, se distingue la evaluación de otras dos actividades, la auditoría y el seguimiento (monitoreo), de enorme importancia en la vida de una política pública; tres ejercicios diferentes que se complementan entre sí. A continuación, se analiza el papel de los indicadores en la lógica de intervención, pasando, en último lugar, a explicitar las ventajas de la evaluación y los diversos factores que pueden dificultarla. Finalmente, se presentan las conclusiones más relevantes.

2. LA EVALUACIÓN DE POLÍTICAS PÚBLICAS: UN POLIEDRO DE MUCHAS CARAS

Ofrecer una respuesta a la pregunta de si es necesaria la evaluación de cualquier actividad realizada por los seres humanos parece una banalidad que en todo caso merece una respuesta afirmativa. La imperfección “natural” que acompaña a todas las actividades humanas y la incertidumbre en la que éstas se desarrollan aconsejan, al menos, una revisión ex-post que nos indique si su realización ha obtenido los resultados previstos o no, es decir, una evaluación. Ahora bien, estando de acuerdo en la necesidad de evaluar todo tipo de actividad humana no es menos cierto que ésta puede conllevar algunos efectos negativos si no está bien enfocada. La evaluación de políticas y programas públicos no constituye una excepción (Miranda Escolar y Miranda Castillo, 2006:99)

Existen, sin embargo, una serie de matizaciones que deben efectuarse porque es evidente que no todas las evaluaciones son iguales. No es lo mismo una evaluación realizada por uno mismo (autoevaluación) que la realizada por un tercero; no es igual la evaluación de una actividad con fines y financiación privados que la de otra con fines y fondos públicos; es diferente la evaluación efectuada por sujetos del mismo nivel jerárquico que la realizada por sujetos de niveles jerárquicos diferentes (inferiores o superiores); y, así, podríamos continuar enumerando distintos tipos de evaluación dependiendo de la relación evaluador-evaluado y de las actividades objeto de examen.

En concreto, la evaluación de políticas y programas públicos podría incluirse, con carácter general, dentro del tipo de evaluaciones en las que el evaluado (la administración, en cualquiera de sus manifestaciones orgánicas o territoriales, y sus actuaciones) realiza las actividades objeto de evaluación con fines y financiación pública. El papel de evaluador correspondería, por tanto, a los sujetos financiadores y receptores de dichas políticas, es decir, a los ciudadanos. En este sentido, es evidente que se realiza una evaluación, con cierta periodicidad, en el momento en que las sociedades democráticas convocan a las urnas a sus ciudadanos para elegir a los responsables de diseñar y poner en marcha dichas políticas. Sin embargo, este modo de “fiscalización electoral” de las políticas públicas presenta ciertos inconvenientes:

el período inter-evaluatorio (entre elecciones) es más o menos fijo (los cuatro años que suele durar una legislatura). Para ciertas políticas este período puede resultar demasiado corto, como es el caso de los programas de desarrollo, mientras para otras, demasiado largo;

sólo permite consideraciones globales respecto del conjunto de políticas aplicadas por un gobierno, resultando difícil extraer conclusiones que contribuyan a mejorar la gestión y ejecución de un programa público concreto, objetivo último de toda evaluación;

influyen, normalmente, otra serie de factores psicosociológicos a la hora de realizar este tipo de evaluación (votación en unos comicios), como puede ser, por ejemplo, la existencia de anclajes ideológicos.

Estas dificultades provocan que la “evaluación electoral” en los sistemas democráticos no baste, por sí sola, para valorar la pertinencia, el diseño, la eficacia, la eficiencia y los impactos (efecto neto) de las distintas políticas y programas que se hayan puesto en marcha. Se necesitan otros sistemas de evaluación que nos ayuden a avanzar hacia una mayor transparencia y rendición de cuentas en la administración pública.

Los sistemas de evaluación surgieron hace años en el ámbito empresarial, fundamentalmente privado, dando lugar a lo que hoy se denomina gestión evaluativa. Sin embargo, esta filosofía ha impregnado, en menor medida, el “quehacer” del sector público1 que hoy se ve en la necesidad de aplicar estos sistemas en un intento de alcanzar mayores niveles de eficacia y eficiencia en la gestión y aplicación de unos recursos financieros cada vez más restringidos con el fin de controlar los niveles de déficit público. A ello habría que añadir la creciente demanda de información por parte de los ciudadanos, que exigen una mayor capacidad de control sobre aquéllos que tienen la responsabilidad de gobernar y de gestionar el dinero público. Las razones que determinan la distribución de estos recursos, así como el éxito o fracaso de las diferentes intervenciones que se pongan en marcha, deben ser explicadas y justificadas. La evaluación debe proporcionar dicha información en un ejercicio de transparencia (rendición de cuentas) y gobernanza.

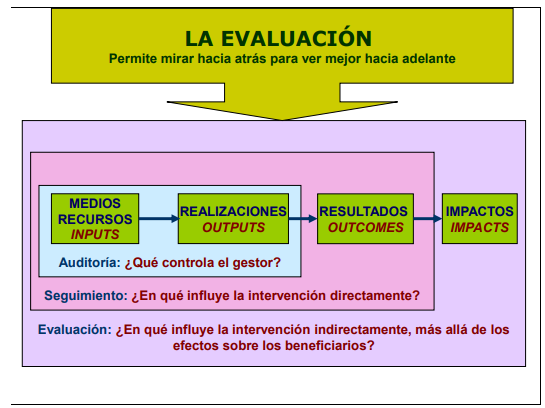

Junto a la evaluación, la auditoría y el seguimiento (monitoreo) constituyen tres actividades diferentes que cumplen distintas funciones en la vida de una política pública pero que se complementan (Figura 1).

La auditoría (control de gestión) se inserta en el contexto organizacional de la práctica administrativa y tiene como objetivo evaluar el desempeño general de la actividad de la administración, tanto a largo plazo, en cuyo caso estaría relacionado con la planificación estratégica, como a corto, vinculándose entonces con la planificación operativa. Con ella, la dirección se asegura que los recursos son obtenidos y empleados de forma eficaz y eficiente para el logro de los objetivos (Ogando y Miranda, 2002:16).

El seguimiento (monitoreo) consiste en realizar un examen exhaustivo, regular (normalmente con periodicidad anual) y sistemático de los recursos financieros ejecutados, las actividades financiadas y los datos sobre los primeros resultados a nivel de proyecto. Debe generar información cuantificada que servirá para corregir las desviaciones respecto a los objetivos fijados inicialmente, contribuyendo a hacer públicos los gastos efectuados y proporcionando los indicadores necesarios para llevar a cabo la evaluación del programa (European Commission, 2014).

La evaluación de programas y políticas públicas es un concepto cuya delimitación es controvertida. Cohen y Franco (1992:72-77) señalan que “evaluar es fijar el valor de una cosa2 y, para hacerlo, se requiere un procedimiento mediante el cual se compara aquello que se va a evaluar respecto de un criterio o patrón determinado”. Puede entenderse, también, como “un método de investigación sistemático sobre la configuración de un programa o política determinada, y sobre su implantación y efectividad”.

En ambas definiciones existen algunos riesgos que deben tenerse presentes. Por una parte, puede darse el caso de haber sobreestimado los objetivos al inicio del programa y considerar como fracaso que no se hayan alcanzado. Por otra, puede suceder lo contrario, una subestimación de los objetivos, de manera que programas mal concebidos y ejecutados podrían tener una evaluación positiva errónea, atribuible bien a que los gestores responsables fueron demasiado cautos en el momento de plantearse las metas a lograr, bien a que los evaluadores fijaron criterios excesivamente prudentes a la hora de realizar la evaluación. Como señalan Bovens y t’Hart (1998:4), “la ausencia de criterios fijos para valorar el éxito o el fracaso de una intervención pública, que se apliquen independientemente del momento y el lugar, es un problema serio”. Se plantea así un modelo centrado únicamente en los objetivos y resultados de las intervenciones gubernamentales, sin prestar la menor atención a los costes del programa ni a otros aspectos de la acción pública de interés para la sociedad (Vedung, 1996:56-59).

Una definición más acertada, desde nuestro punto de vista, es la que ofrecen Meny y Thoenig (1992:195) cuando señalan que “evaluar una política pública es apreciar los efectos atribuibles a una intervención gubernamental en un campo específico de la vida social y del entorno físico. La evaluación es, por tanto, un camino, un modo de razonamiento asumido por el analista: la apreciación sistemática, sobre la base de métodos científicos, de la eficiencia y de los efectos reales, previstos o no, buscados o no, de las políticas públicas”. Con otras palabras, pero en esta misma línea, Vedung (1996:17-20) describe la evaluación como una buena práctica que “permite mirar hacia atrás con el fin de poder ver mejor hacia adelante”.

Para otros autores (Fahrenkrog et al., 2002), “la evaluación es un proceso sistemático y objetivo que valora la relevancia, eficiencia y eficacia de las políticas, programas y proyectos a partir de los objetivos establecidos. Un proceso que incorpora en paralelo una aproximación teórica y práctica, y cuyos resultados realimentan la acción política, provocando un proceso continuo de aprendizaje. Desde este presupuesto, la evaluación permite incorporar una dinámica de transparencia y rendición de cuentas al proceso político que enriquece la lógica de la formulación y la revisión política”. Ahora bien, como señala Scriven (2008), “la evaluación es lo que es, la determinación de mérito o valor, para lo que sea utilizada es otra cuestión”.

En esta misma línea, la Organización para la Cooperación y el Desarrollo Económicos (OCDE, 2010) considera que “la evaluación es la apreciación sistemática y objetiva de un proyecto, programa o política en curso o concluido; de su diseño, de su puesta en práctica y de sus resultados; cuyo propósito es determinar la pertinencia y el logro de los objetivos, así como su eficiencia, el impacto y la sostenibilidad para el desarrollo […] y deberá proporcionar información creíble y útil que permita incorporar las enseñanzas aprendidas en el proceso de toma de decisiones de beneficiarios y donantes”. Se incorporan así elementos clave de la evaluación como: pertinencia, eficiencia, sostenibilidad, transparencia, utilidad, eficacia y aprendizaje.

Hemos querido contribuir a este debate proponiendo una definición en la que encuentran cabida muchos de los aspectos que puede abarcar el concepto de evaluación de políticas públicas, y que es fruto de la experiencia de más de veinticinco años trabajando sobre el terreno y experimentando con diferentes métodos y técnicas para estimar “el valor” de algunas intervenciones que se han puesto en marcha en diferentes ámbitos. Para nosotros, “la evaluación consiste en la aplicación de técnicas de investigación sistemáticas al objeto de examinar el diseño, la ejecución y la utilidad de una política o de un programa público, indicando un camino a seguir para estimar, sobre la base de métodos científicos, la eficacia (efectividad), la eficiencia y el impacto neto, previsto o no, de las políticas públicas en los ámbitos económico, social, medioambiental… y en el entorno físico. Es un proceso generador de información (cuantitativa y cualitativa) e indicadores relevantes que retroalimentan la política para mejorar su gestión y la calidad de futuras intervenciones”.

En un contexto en el que los responsables políticos y la sociedad civil exigen resultados y rendición de cuentas a los programas públicos, la evaluación se ha convertido en un instrumento que debe contemplarse como parte integral de la toma de decisiones de política pública. Pero ésta no es una tarea sencilla. Evaluar un programa o una política pública supone adoptar una visión abierta en materia de metodologías y técnicas (cuantitativas y cualitativas) a utilizar, así como asumir diferentes corrientes de pensamiento dentro de las ciencias sociales y de la teoría de la administración pública. No se trata únicamente de la aplicación de una metodología o una técnica; es, también, un enfoque a través del cual el evaluador se acerca al objeto de evaluación. Este enfoque tiene que ver con su propia posición ante la realidad, con su visión sobre el objeto a estudiar, con paradigmas emergentes y dominantes y con el contexto en el que se desenvuelve la tarea evaluativa.

Se distinguen cinco tipos diferentes de evaluación que resultan de la combinación de los enfoques metodológicos y la finalidad a la que responde cada uno de ellos (Him, 2017:58-59):

las orientadas a la planificación y asignación de recursos, que responden a evaluaciones de carácter económico;

las relacionadas con la rendición de cuentas que se corresponden con evaluaciones orientadas hacia la gestión, la eficacia y la eficiencia;

las que intentan ofrecer explicaciones sobre los fenómenos observados estableciendo un vínculo causal entre la política y sus efectos, a partir de metodologías experimentales o cuasi-experimentales (evaluaciones de impacto);

las enfocadas a la implementación y ejecución que buscan la mejora y el cambio internos, objeto de las evaluaciones formativas; y

las que pretenden el fortalecimiento institucional a partir de metodologías de desarrollo organizacional y participativo, objetivo propio de las evaluaciones participativas.

Cada uno de estos tipos de evaluación se focaliza hacia diferentes aspectos concretos de la vida de un programa, su caja negra, donde se encuentra todo lo que ocurre en él: acciones, decisiones, recursos, personas e interacciones. Se espera que la combinación de todos estos factores produzca los resultados previstos. Realmente un programa es esto, ya que los resultados son las salidas que incluso pueden considerarse una variable exógena porque es lo que trasciende de los límites de la intervención (Ligero, 2011).

3. EL PAPEL DE LOS INDICADORES EN LA LÓGICA DE INTERVENCIÓN: CATEGORIZACIÓN

Un elemento determinante del éxito de la evaluación lo constituye el hecho de poder disponer de un buen sistema de seguimiento y de una batería de indicadores adecuados para tal finalidad. Un indicador es una observación empírica que sintetiza aspectos importantes de un fenómeno para uno o más propósitos analíticos o prácticos. Si bien el término puede aludir a cualquier característica observable de un fenómeno, suele aplicarse a aquéllas que son susceptibles de expresión numérica. Sin embargo, aunque la información proporcionada por los indicadores generalmente se refleja en datos de carácter cuantitativo, la evaluación no puede permitirse excluir de su ámbito de análisis un aspecto relevante simplemente porque es difícil de medir en términos numéricos. Es aquí donde puede ser recomendable el uso de indicadores cualitativos, descripciones en forma de declaración concisa, clara y estable.

Los indicadores tienen una importante misión que cumplir en la evaluación de cualquier programa o política pública y ocupan un lugar específico en la lógica de la intervención. Un indicador es la unidad que permite medir el alcance de una meta o la medición de un objetivo a conseguir, un recurso movilizado, un efecto que se obtiene o una variable de contexto que produce una información cuantitativa y que ayuda a los actores involucrados en las intervenciones públicas a tomar decisiones (European Commission, 2012, 2014). Las características que deben tener los indicadores para desempeñar adecuadamente su función en la evaluación se resumen en las siguientes:

deben reflejar con precisión lo que se supone que miden (validez de la construcción);

deben ser sensibles, es decir, la cantidad medida debe variar significativamente cuando ocurre un cambio en la variable a medir;

deben utilizarse métodos de recopilación de datos fiables;

deben medirse periódicamente para disponer de información sobre los progresos del programa;

deben ofrecer información sencilla que sea fácil de comprender y de comunicar, tanto para el proveedor como para el usuario;

deben ayudar a los gestores públicos de la intervención a comunicar, negociar y decidir.

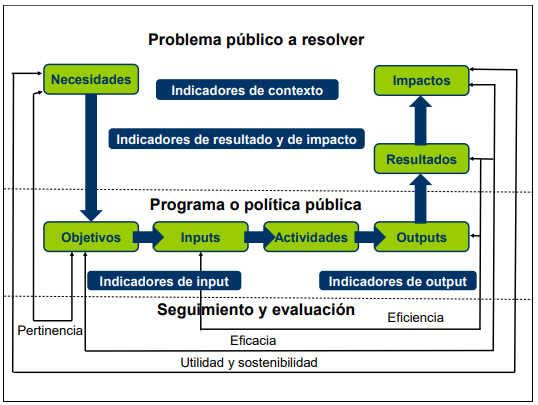

La Comisión Europea reconoce, básicamente, cinco tipos diferentes de indicadores para llevar a cabo la evaluación de una política pública, siguiendo la cadena causal de la lógica de intervención (European Commission, 2014):

Indicadores de contexto. Se utilizan para describir la situación de partida del ámbito (territorial, socioeconómico, sectorial, ambiental,…) en el que se aplicará la estrategia y contra el que se contrastarán los resultados e impactos logrados por el programa. Son útiles para realizar el análisis DAFO en la evaluación ex-ante y ayudarán a reflejar los cambios en el entorno debidos al programa. Cumplen una doble finalidad: (i) contribuir a determinar los puntos fuertes y débiles del ámbito en el que se aplicará el programa y (ii) ayudar a interpretar sus logros a la luz de las tendencias económicas, sociales y medioambientales generales. Se vinculan con los objetivos generales del programa y se obtienen de fuentes estadísticas oficiales (datos secundarios). Responden a la pregunta: ¿qué problemas deben resolverse con la intervención y qué aspectos debe impulsar el programa?

Indicadores de medios y recursos. Se refieren al presupuesto o a otros recursos asignados a cada nivel de la intervención. Los indicadores financieros se utilizan para realizar el seguimiento de los avances del programa desde el punto de vista del compromiso y el pago (anual) de los fondos disponibles para toda operación y medida, así como para el programa en su conjunto. Responden a la pregunta: ¿de qué recursos se dispone para ejecutar el programa (o sus actuaciones)?

Indicadores de realización, de ejecución o de output. Miden las actividades realizadas directamente dentro del programa y son el primer paso para la consecución de los objetivos operativos de la intervención. Se extraen del sistema de seguimiento del programa. Responden a las preguntas: ¿qué controla el gestor público con la intervención? ¿cuál es el producto de la política?

Indicadores de resultados. Pretenden cuantificar los efectos directos e inmediatos de la intervención. Proporcionan información sobre los cambios de comportamiento, de las capacidades o de la actuación de los beneficiarios directos. Responden a la pregunta: ¿en qué influye directamente la intervención a través de cambios en el comportamiento o las capacidades de los beneficiarios del programa?

Indicadores de impacto. Se refieren a los beneficios del programa más allá de los efectos inmediatos en sus beneficiarios directos y están vinculados con los objetivos generales del programa. Se expresan en términos «netos», es decir, teniendo en cuenta sólo los efectos que son imputables a la intervención y sólo a ella, lo que supone descontar aquellos que no pueden atribuirse a la intervención (como el peso muerto, efectos que se habrían producido aunque la intervención no se hubiese llevado a cabo) y deben tener en cuenta los efectos indirectos (efectos desplazamiento, que son los efectos obtenidos en un área de apoyo del programa a expensas de otras que no lo están y multiplicador). Los indicadores de impacto son, quizá, los más importantes para evaluar el éxito de una intervención. Se utilizan también para describir la situación inicial (por ello se pueden incluir también como indicadores de contexto). Responden a la pregunta: ¿en qué influye indirectamente la intervención más allá de los efectos en los beneficiarios del programa?

La regla básica para disponer de un buen sistema de indicadores descansa en utilizar un número reducido, que contengan información relevante y que estén claramente definidos para poder emitir juicios sólidos y conclusiones, con el fin de que puedan ser traducidos en mensajes claros dirigidos a los gestores públicos y a la sociedad en general. Los indicadores deben facilitar una interpretación clara y reflejar los cambios deseables y realizables de la lógica de intervención. La importancia de los indicadores de seguimiento y evaluación reside en que posibilitan la medición de los efectos y avances de los programas públicos. Existe un vínculo entre la definición de los indicadores y la necesidad de diseñar métodos robustos que permitan medir el grado en que el cambio del indicador pueda ser atribuible a la intervención. Es responsabilidad del gestor público garantizar la disponibilidad de datos de calidad que provengan de diferentes fuentes de información (internas y externas), lo que no siempre es posible (Him et al., 2019:206).

Generalmente, la administración posee una gran cantidad de información que permite describir y medir, sobre todo, la asignación de sus recursos (inputs) y los outputs que producen. Sin embargo, el evaluador se interesa más por los impactos de tales actuaciones (el efecto neto).

En general, la carencia de datos disponibles sobre estos efectos contrasta con la abundancia de estadísticas de carácter interno sobre los medios. Es poco frecuente que los programas y las políticas públicas cuenten, desde su nacimiento, con un dispositivo que permita recopilar aquellos datos que posibiliten la medición de sus impactos en términos netos, por ejemplo a través de la construcción de un escenario contrafactual3. De ahí, la necesidad que tiene el evaluador de diseñar las metodologías más apropiadas (o más factibles) e incluso de diseñar y cuantificar a posteriori los indicadores de impacto, bien directamente4, bien recurriendo a indicadores indirectos que faciliten una buena aproximación (indicadores proxy).

Los indicadores desempeñan un papel fundamental dentro de la lógica de intervención, un instrumento metodológico que representa el conjunto de supuestos efectuados para explicar el modo en que la intervención producirá los efectos esperados. Muestra la relación conceptual que se establece entre los recursos de una intervención (inputs) y sus realizaciones (outputs) y, posteriormente, entre sus resultados e impactos. Es una simplificación de la realidad que permite efectuar una evaluación de la contribución de las actuaciones incluidas en un programa público al logro de sus objetivos. Los elementos que configuran la lógica de intervención se muestran en la Figura 2 a través de un diagrama dividido en tres niveles, cada uno de ellos separados por una línea horizontal. La evaluación se sitúa en el nivel inferior formando parte del proceso de planificación (evaluación ex-ante o a priori). Una vez ha sido identificado el problema público a resolver (económico, social, medioambiental…), el objetivo de la intervención (nivel superior), se diseña el programa, se establecen los objetivos a alcanzar y se asignan los recursos necesarios para su ejecución (nivel intermedio). Los resultados e impactos se encuentran en el nivel superior porque afectan a las necesidades y los problemas a resolver; es decir, al entorno socioeconómico (se actúa para cambiar las cosas). Como señalan Cohen y Franco (1992), “si planificar es introducir organización y racionalidad en la acción para el logro de determinadas metas y objetivos, la evaluación es una manera de verificar esa racionalidad, midiendo el cumplimiento de los objetivos y metas previamente establecidos y la capacidad para alcanzarlos”.

Las necesidades hacen referencia a las características socioeconómicas, medioambientales o culturales que han generado el problema público sobre el que pretende incidir el programa (mediante el análisis DAFO deben identificarse los riesgos, debilidades, motores, oportunidades y fortalezas del entorno, así como los grupos objetivo). Los inputs son recursos financieros, administrativos y materiales que se movilizan para generar los outputs (realizaciones), bienes (tangibles e intangibles) y servicios producidos directamente por las actividades del programa (acciones emprendidas y trabajo realizado) que se encuentran bajo el control y la responsabilidad del organismo (departamento/servicio) gestor y que irán encaminados a alcanzar los objetivos operativos. Los resultados son los efectos más inmediatos de las acciones del programa que se derivan de los cambios en el comportamiento de los beneficiarios y contribuyen al logro de los objetivos específicos. Los impactos están relacionados con los objetivos generales del programa, que pueden verse influidos por múltiples factores ajenos a la intervención y que se alcanzan después de un período largo de tiempo, afectando a las necesidades que fueron identificadas previamente y que condujeron a la aplicación del programa5.

Dentro de la lógica de intervención, es preciso plantearse algunas preguntas de evaluación para cuya respuesta se deben fijar criterios y juicios que recaen principalmente en las siguientes categorías:

(i) pertinencia, (ii) eficacia, (iii) eficiencia, (iv) utilidad y (v) sostenibilidad. La Comisión Europea menciona alguna más, como la coherencia interna y externa o las sinergias con otras intervenciones.

La pertinencia, en el contexto de una evaluación, se refiere a las relaciones existentes entre los objetivos del programa y los problemas que este pretende abordar. Por ello, resulta crucial la veracidad y calidad del diagnóstico que se realice. Normalmente, el análisis de pertinencia suele llevarse a cabo en la evaluación ex-ante, donde se trata de una cuestión crucial, al orientar la elección de la estrategia más adecuada antes de poner en marcha el programa. Esta cuestión es extremadamente delicada y constituye uno de los aspectos más políticos de la evaluación. No hay que olvidar que una política pública se justifica por el surgimiento de un problema público (necesidades) al que los responsables políticos deben hacer frente. Requiere un análisis DAFO coherente y robusto.

La eficacia mide el grado en que se han alcanzado los objetivos del programa evaluado sin considerar los costes en los que se ha incurrido para ello. Requiere una definición clara y precisa de los objetivos.

La eficiencia relaciona los inputs (recursos) movilizados en el programa con los outputs (realizaciones) y los resultados obtenidos. Un análisis de eficiencia intenta averiguar si los mismos productos y resultados podrían haberse conseguido con un coste más bajo. Requiere la comparación de alternativas.

La utilidad trata de averiguar si el programa evaluado ha contribuido a realizar cambios favorables en la sociedad desde la perspectiva de los beneficiarios. La selección de las necesidades o problemas a resolver no debe ser subjetiva, por ello es conveniente involucrar a los beneficiarios del programa en dicha elección. Requiere la participación de todos los actores.

La sostenibilidad pretende valorar lo que puede suceder después de que el programa haya terminado; es decir, determinar si los impactos se mantienen en el tiempo o, por el contrario, tienen un efecto limitado. Requiere información longitudinal de beneficiarios y proyectos apoyados por el programa.

4. FACTORES A FAVOR Y EN CONTRA DE LA EVALUACIÓN

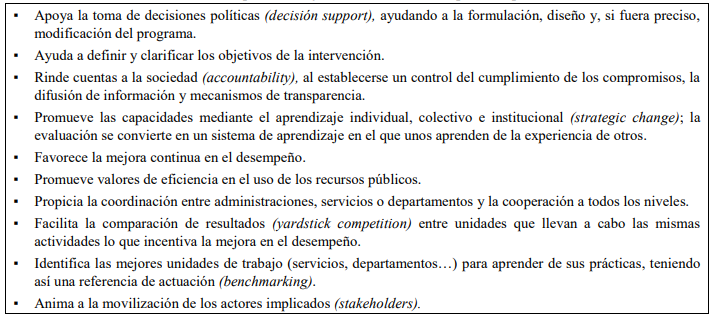

Cabe atribuir a la evaluación tres funciones básicas: apoyo a la toma de decisiones políticas (decision support), ayudando a la formulación, diseño y, si fuera preciso, modificación del programa; rendición de cuentas (accountability), que incluye el control del cumplimiento de los compromisos adquiridos, la información y transparencia; y, aprendizaje (strategic change) individual, colectivo e institucional. En este último caso no se pueden utilizar indicadores convencionales, pero se pueden seleccionar algunos comportamientos que ponen de manifiesto el buen hacer de instituciones y personas. Una vez sean seleccionados como buenas prácticas, podrán ser replicados en otros lugares contribuyendo, así, a que la evaluación se convierta en un sistema de aprendizaje en el que unos aprenden de la experiencia de otros (benchmarking).

Inicialmente, la evaluación estuvo centrada en los mecanismos de programación, implantación y ejecución de las políticas y programas públicos (la caja negra), prestándose escasa atención al impacto de las actuaciones financiadas. De hecho, en la tercera edición6 de Implementation(Pressman y Wildavsky, 1984), se dedicaba un capítulo al significado de la evaluación de la implantación que pretendía establecer una relación entre el estudio de esta etapa del ciclo de una política pública con el interés que en aquel momento estaba comenzando a despertar la evaluación: “el evaluador recoge y analiza datos para proporcionar información sobre los resultados del programa. El implantador consume esta información, utilizándola para comprobar las decisiones pasadas y orientar las acciones futuras. La implantación (…) trata de aprender de la evaluación. Los ejecutores y los evaluadores se involucran en relaciones complementarias basadas en su mutua producción y consumo de información (es decir, aprendizaje)”.

Sin embargo, en los últimos años, se han realizado grandes esfuerzos desde diferentes organismos internacionales (Banco Mundial, Comisión Económica para América Latina y el Caribe o la Comisión Europea, entre otros) por impulsar la evaluación de impacto de las intervenciones públicas. En todo caso, la evaluación de impacto sería sólo una parte más de la evaluación de un programa o de una política pública.

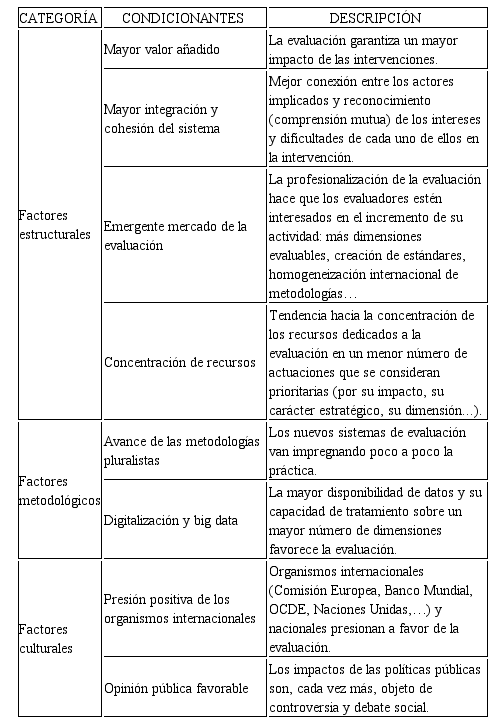

Las experiencias de países con larga trayectoria en evaluación en todos los niveles de la administración, como son los casos de Estados Unidos, Canadá, Francia y los países nórdicos, han demostrado las múltiples ventajas de la evaluación de políticas públicas al permitir el intercambio de ideas entre los actores involucrados en la intervención, aspecto que permite legitimar la acción pública, mejorar la gestión y explicar los resultados y sus efectos indirectos o no previstos; es decir, en qué medida ha logrado modificar el tejido social que se buscaba afectar (cambiar) y hasta qué punto esos efectos satisfacen las expectativas de las decisiones tomadas. Creemos que, en parte, ello se conseguiría mediante la difusión de los resultados de la evaluación, haciendo partícipes del éxito o del fracaso del programa a los decisores políticos y a la sociedad en su conjunto, destinataria última de las políticas públicas que se instrumenten. Las principales ventajas de la evaluación de políticas públicas se resumen en la Tabla 1.

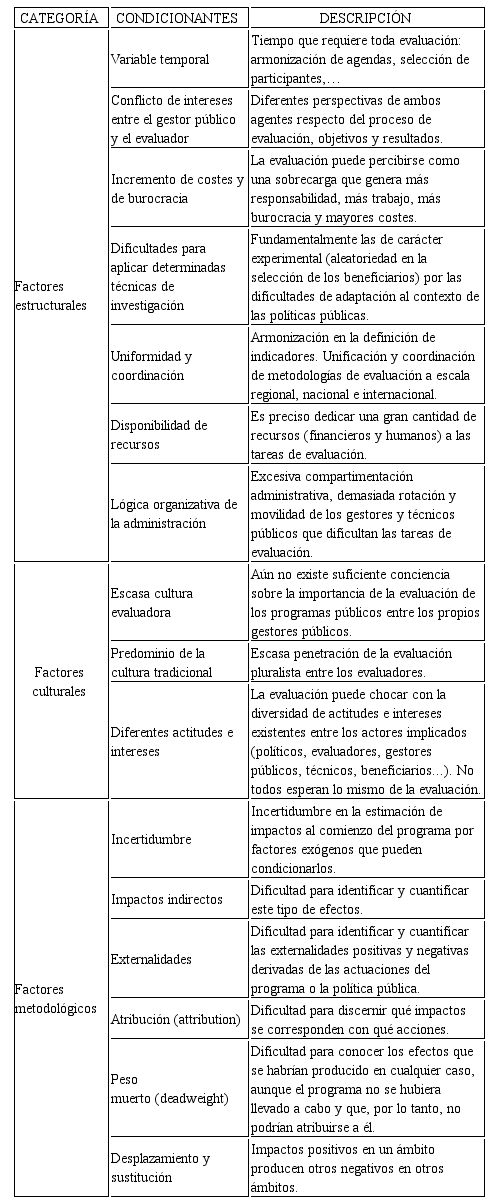

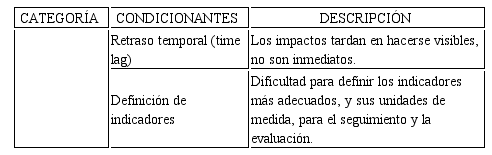

No obstante, a pesar de estas nada desdeñables ventajas, pueden presentarse dificultades de muy diversa índole a la hora de implantar sistemas de evaluación de políticas públicas en la administración, lo que pone de manifiesto la complejidad de esta tarea. Sin ánimo de ser exhaustivos, la Tabla 2 que se presenta a continuación resume, a nuestro juicio, los distintos factores que pueden dificultar las tareas de seguimiento y evaluación de políticas públicas.

Como puede observarse, estos factores se han agrupado en tres categorías principales:

factores estructurales, relacionados con la arquitectura y el funcionamiento de las organizaciones e individuos involucrados en el programa;

factores culturales, que tienen que ver con la actitud, el comportamiento y la mentalidad de los actores; y

factores metodológicos, asociados a los requerimientos y exigencias que impone el método científico y que interfieren con el modus operandi y la propia lógica de las políticas públicas.

Entre los factores más relevantes que pueden dificultar los procesos de evaluación, se destacan los siguientes:

la identificación de los objetivos originales de la política;

el diseño y la cuantificación de indicadores adecuados;

el aislamiento de los efectos imputables a la política de otros factores exógenos a la intervención (el efecto neto); y

el contexto político.

Los tres primeros caerían dentro de lo que hemos denominado factores metodológicos y pueden resolverse mediante el diseño de un proceso de evaluación adecuado, pero el cuarto no puede controlarse totalmente. Aunque la evaluación intenta valorar una política pública de una manera objetiva, las tareas de evaluación se desarrollan en un marco político, lo que significa que los decisores públicos (policy-makers) podrían estar interesados en destacar los hallazgos que proyecten una imagen positiva de ellos y ocultar aquellos otros que les coloque en mal lugar. Además de esta amenaza potencial, también existen limitaciones prácticas derivadas del contexto político; por ejemplo, los responsables políticos suelen requerir información inmediata sobre los efectos de una política (sobre todo si estos son positivos), aunque la mayoría se dejen sentir en el largo plazo.

Paralelamente, existe, también, una serie de condicionantes positivos (factores a favor) que favorecen la introducción de los sistemas de evaluación de los programas públicos en el conjunto de actividades de la administración. La Tabla 3 resume los que consideramos más significativos, agrupados, igualmente, en las tres categorías principales anteriormente utilizadas.

5. CONCLUSIONES

Las instituciones desempeñan un papel clave en la forma en que las sociedades distribuyen los beneficios y los costes de las políticas públicas que se ponen en marcha, siendo imprescindible contar con normas sólidas que garanticen la calidad de la información, la transparencia en la gestión y el ejercicio de un buen gobierno. Es aquí donde la evaluación de programas y políticas públicas cobra todo su sentido, porque tal vez los mayores beneficios de la evaluación no sean los resultados directos que genera en términos de lo que pondría de manifiesto una evaluación de impacto, sino la dinámica de aprendizaje que puede estimular entre los responsables políticos y los gestores públicos, así como en los demás actores involucrados en la intervención, las mejoras en gobernanza o los cambios institucionales que se pueden derivar de ella. Tampoco debe obviarse su vertiente política pues, en sí misma, la evaluación implica una decisión política, de ahí que se vea como un instrumento del Estado para hacer más transparente la acción política y mejorar la eficiencia gestora del sector público. Bajo esta perspectiva, la evaluación es un proceso más que una mera técnica. Implantar de forma sistemática la evaluación de políticas públicas en diferentes ámbitos de la administración contribuye a crear instituciones fuertes al servicio del ciudadano pero también requiere un cambio de mentalidad entre los trabajadores públicos, que deben aceptar que sus actuaciones sean evaluadas, incorporar la evaluación a sus herramientas de trabajo y reconocer

las ventajas de la evaluación en vez de considerarla una amenaza y una sobrecarga. Esta es la dirección en la que debe avanzar la administración y el reto para las próximas décadas.

REFERENCIAS

Albi, E. y Onrrubia, J. (2015). Economía de la gestión pública. Cuestiones fundamentales. Madrid: Editorial Universitaria Ramón Areces.

Bovens, M. & t’Hart, P. (1998). Understanding Policy Fiascoes. New Brunswick: Transaction Publishers.

Brown, D. (2001). Evaluación de políticas y programas en la región del Caribe de habla inglesa: problemas conceptuales y prácticos. Serie Gestión Pública (9). Santiago de Chile: Instituto Latinoamericano y del Caribe de Planificación Económica y Social (ILPES),

Cohen, E. y Franco, R. (1992): Evaluación de proyectos sociales. México: Siglo Veintiuno Editores.

European Commission (2012). Evalsed: The Resource for the evaluation of Socio-Economic Development. Brussels: European Commission.

European Commission. Agriculture and Rural Development (2014). Capturing the Success of your RDP: Guidelines for the Ex-post Evaluation of 2007-2013 RDPS. Brussels: European Evaluation Network for Rural Development. Recuperado de: http://enrd.ec.europa.eu/evaluation

Fahrenkrog, G. (Ed.) (2002). RTD Evaluation Toolbox, Assessing the Socio-Economic Impact of RTD Policies. Sevilla: European Commission-Joint Research Centre, IPTS.

Him Camaño, M.I. (2017). Las transferencias monetarias condicionadas como instrumento de reducción de la pobreza: Incidencia sobre la formación de capital humano del Programa Red de Oportunidades (2010-2014) en Panamá. (Tesis Doctoral en Economía, no publicada). Universidad de Valladolid. Valladolid (España).

Him Camaño, M.I.; Miranda Escolar, B.; Corrales Herrero, H. y Ogando Canabal, O. (2019). Evaluación de la gobernanza del Programa Red de Oportunidades de Panamá: Logros alcanzados y retos pendientes. Estudios de Economía Aplicada, Vol. 37-1, 192-209.

Ligero Lasa, J.A. (2011). Dos métodos de evaluación: Criterios y teoría del programa.. Documento de trabajo. Serie CECOD, 15. Madrid: Instituto Universitario de Estudios Europeos, CEU. Universidad San Pablo, 1-67.

Mairate, A. (2003). La Evaluación de los Fondos Estructurales: Aspectos Metodológicos y Teóricos. En O. Ogando y B. Miranda, Evaluación de Programas e Iniciativas Comunitarias: Experiencias, Nuevas Orientaciones y Buenas Prácticas. Valladolid: Instituto de Estudios Europeos. Universidad de Valladolid, 45-75.

Meny, I. y Thoenig, J.C. (1992). Las políticas públicas. Barcelona: Editorial Ariel.

Miranda Escolar, B. y Miranda Castillo, J.C. (2006). La evaluación de políticas y programas públicos: Algunas precisiones conceptuales. En la obra colectiva: La Nueva Región de Los Ríos. Una mirada desde la Universidad. Valdivia: Ediciones Universidad Austral de Chile, 99-125.

OCDE (2010). Glosario de los principales términos sobre evaluación y gestión basada en resultados. París: OCDE. Recuperado de: http://www.oecd.org/dac/evaluationnetwork

Ogando Canabal, O. y Miranda Escolar, B. (2002). La evaluación de las políticas públicas: Aspectos metodológicos y estudio de casos. En la obra colectiva: Evaluación y control de políticas públicas: Indicadores de gestión. Gijón: Ayuntamiento de Gijón, 12-42

Pedrosa Sanz, R., Miranda Escolar, B., Moñux Chércoles, D., Aleixandre Mendizábal, G. y Gómez González, F. J. (2005). Análisis del impacto social de la política regional de I+D+i en Castilla y León: Una propuesta de indicadores para su evaluación. Proyecto de investigación financiado por la Consejería de Educación de la Junta de Castilla y León, España (Proyecto VA097/04).

Pressman, J.L. & Wildavsky, A. (1984). Implementation. Berkeley: University of California Press.

Scriven, M. (2008). Summative Evaluation of RCT Methodology: An Alternative Approach to Causal Research. Journal of Multidisciplinary Evaluation 5(9), 11-24.

Vedung, E. (1996). Evaluación de políticas públicas y programas. Madrid: Instituto Nacional de Servicios Sociales. Ministerio de Trabajo y Asuntos Sociales.

Notas