Determinación del riesgo de diabetes en México mediante un sistema difuso optimizado por recocido simulado

Determination of the risk of diabetes in Mexico through a simulated annealing optimized fuzzy system

Revista de Investigación en Tecnologías de la Información

Universitat Politècnica de Catalunya, España

ISSN-e: 2387-0893

Periodicidad: Bianual

vol. 10, núm. 20, 2022

Recepción: Abril 22, 2022

Aprobación: Junio 20, 2022

Resumen: Según la Organización Mundial de la Salud, aproximadamente el 70% de los adultos en México padecen sobrepeso u obesidad, factores determinantes en el desarrollo de diabetes mellitus tipo 2. Además, según el Instituto Nacional de Salud Pública, 10.3% de los mayores de 20 años padecen diabetes. Para facilitar las tareas de decisión o clasificación al momento de tratar a un paciente, los expertos desarrollan sistemas basados en lógica difusa, sin embargo, este diseño no suele ser infalible, por lo que es común optimizarlos para mejorar su rendimiento. El presente trabajo muestra los resultados de una comparación entre la eficiencia en la predicción de riesgo de padecimiento de diabetes tipo 2, establecida por la prueba de FINDRISC y de un sistema difuso de diseño propio optimizado por la heurística de Recocido Simulado para 295 pacientes de Acapulco, México. La comparación muestra que el sistema difuso obtiene la misma sensibilidad, pero valores superiores de especificidad y, valores predictivos positivos y negativos con mejoras generales en los intervalos de confianza, concluyendo que utilizar el sistema propuesto como auxiliar en la prevención de diabetes tipo 2 es viable y arroja resultados apegados a la realidad de los pacientes.

Palabras clave: Predicción de Riesgo, Diabetes, Lógica Difusa, Recocido Simulado, Optimización.

Abstract: According to the World Health Organization, approximately 70% of adults in Mexico are overweight or obese, determining factors in the development of diabetes mellitus type 2. In addition, according to the National Institute of Public Health, 10.3% of those over 20 years old suffer from diabetes. To facilitate decision or classification tasks when treating a patient, experts develop systems based on fuzzy logic, however, this design is not usually infallible, so it is common to optimize them to improve their performance. The present work shows the results of a comparison between the efficiency in predicting the risk of suffering from type 2 diabetes established by the FINDRISC test and an own design fuzzy system optimized by the Simulated Annealing heuristic for 295 patients from Acapulco, Mexico. The comparison shows that the fuzzy system obtains the same sensitivity, but higher specificity values and positive and negative predictive values with general improvement in the confidence intervals, concluding that using the proposed system as an aid in the prevention of type 2 diabetes is viable and yields results attached to the reality of the patients.

Keywords: Risk Prediction, Diabetes, Fuzzy Logic, Simulated Annealing, Optimization.

1. Introducción

La Organización Mundial de la Salud (OMS), en su informe mundial sobre diabetes menciona que aproximadamente el 70% de los adultos en México padecen sobrepeso u obesidad, factores importantes en el desarrollo de diabetes mellitus tipo 2. Además, el Instituto Nacional de Salud Pública (INSP), en la Encuesta Nacional de Salud y Nutrición, notifica que en México 8.6 millones de personas mayores de 20 años han sido diagnosticadas con diabetes, correspondientes al 10.3% de este sector de la población [1, 2].

En el campo médico con el propósito de facilitar las tareas de decisión o clasificación al momento de tratar a un paciente, y para prevenir problemas de diabetes, se han desarrollado diversos sistemas basados en lógica difusa, no obstante, cuando se desarrolla cualquier sistema de este tipo, es de vital importancia tener una adecuada selección de las funciones de membresía y sus parámetros asociados, así como de las reglas que rigen al sistema, pues de lo contrario, el software arrojará resultados que no describen la realidad. Estos sistemas, si bien en principio suelen ser diseñados por un experto en el tema, la configuración humana puede no ser la más adecuada, por lo que no es raro hacer uso de algoritmos basados en experiencia con el objetivo de hallar configuraciones viables que ayuden al sistema a resolver el problema. Dichos algoritmos, también llamados métodos metaheurísticos, han servido para optimizar sistemas en múltiples áreas, logrando así describir la realidad de manera acertada. Lo expuesto anteriormente, justifica el apoyarse en sistemas computacionales que permitan conocer el riesgo de padecimiento de la ya mencionada enfermedad para llevar a cabo tareas de prevención.

En esta investigación se muestran los resultados de desarrollar un sistema de lógica difusa para determinar el porcentaje de riesgo de padecimiento de diabetes mellitus tipo 2, de un paciente con base en datos clínicos sencillos de obtener. Las funciones internas del sistema fueron optimizadas con la técnica heurística de Recocido Simulado, el sistema es probado con los datos de 295 pacientes reales de la ciudad de Acapulco en México [3], la efectividad en términos de valor predictivo positivo, valor predictivo negativo, sensibilidad y especificidad es comparada con la obtenida por la prueba de FINDRISC como estándar de oro, misma que se utiliza como prueba de tamizaje para predecir el riesgo de padecimiento de diabetes tipo 2 dentro de los próximos 10 años de vida del individuo.

A continuación, en la sección 2 se revisan algunas aportaciones relacionadas que utilizan sistemas difusos para tareas de prevención de diabetes, la sección 3 muestra los conceptos fundamentales de la lógica difusa, el algoritmo heurístico de Recocido Simulado y el estándar de oro de la prueba de FINDRISC, así como las métricas de interpretación de estudios de exactitud diagnóstica utilizadas para la evaluación del rendimiento de las pruebas diagnósticas, así como la descripción del sistema elaborado, además de introducir la base de datos utilizada. En la sección 4 se encuentra la tabla comparativa entre resultados de la prueba de FINDRISC y el sistema difuso, posteriormente, en la sección 5 se discuten los hallazgos y se establecen las conclusiones. La sección 6 contiene los agradecimientos que desean hacer los autores y finalmente, en la sección 7 las referencias.

2. Estado del arte

En esta sección se describen algunos trabajos involucrados en la detección y clasificación de pacientes con diabetes a través de sistemas basados en lógica difusa y optimizados por métodos heurísticos, así como su eficiencia obtenida.

En 2017, Reddy y Khare [4], publican un estudio que establece una predicción para problemas cardiacos y riesgo de padecimiento de diabetes. Usando teoría de conjuntos aproximados y binarización de los datos provenientes de la base de datos de la UCI, de un total de 13 factores de riesgo como edad, sexo, IMC, entre otros, se seleccionaron 6 para después normalizarlos y optimizarlos usando la heurística de Búsqueda Cuckoo, posteriormente un experto diseña funciones de membresía triangulares que no son optimizadas. Para evaluar el desempeño, se revisa tanto la precisión respecto al corpus, como la sensibilidad y especificidad, la puntuación fue de 91%, 94% y 90% respectivamente. Al establecer una comparación contra un sistema basado en búsqueda por luciérnagas y murciélagos, se nota que los 3 criterios son mejores, superando el 68%, 79% y 84% de dicho estudio, y el 72.6%, 100% y 0% de un sistema ya existente en la industria, aunque con otros conjuntos de datos se puede percibir un rendimiento inferior al esperado, el estudio concluye enfatizando la reducción de los datos en más del 50%.

También en 2017, Sahu, Verma y Reddy [5], obtuvieron una serie de datos no especificados de un laboratorio patológico local, dichos datos se redujeron utilizando Reducción por Preservación Local de Proyecciones y las reglas del sistema se calcularon utilizando Búsqueda por Colonia de Hormigas, estas reglas fueron optimizadas usando la técnica de Búsqueda Cuckoo, las funciones de membresía se diseñaron con forma triangular por un experto y no fueron optimizadas. Se utiliza la precisión de los resultados respecto al corpus consultado, así como la sensibilidad y especificidad para medir la eficacia del sistema en 10 ejecuciones, luego se compara contra otra implementación del mismo sistema optimizado mediante un híbrido de Búsqueda por Luciérnagas y Murciélagos. Se concluye que el uso de Búsqueda Cuckoo muestra un mejor rendimiento que la variante Luciernaga-Murciélago, sin embargo, los resultados en cada ejecución son variables en el porcentaje de precisión del sistema oscilando entre 64% y 74%.

En el 2020, Bressan, Flamia de Azevedo y Molina de Souza [6], desarrollan un clasificador difuso para catalogar a un grupo de personas como pacientes que requieren atenciones básicas o que requieren atenciones especializadas. Partiendo de los datos clínicos de edad, triglicéridos, tiempo de evolución de la enfermedad, IMC, ingresos per cápita, circunferencia abdominal y tiempo de escolaridad proporcionados por el Unified Health System de Brasil, un experto descartó los atributos no esenciales y, usando un árbol de decisión con el algoritmo C4.5 se generaron todas las reglas requeridas por el sistema. Se hizo una implementación para cada grupo, las funciones de membresía se eligieron con forma triangular y se ajustaron haciendo uso de un Sistema de Inferencia Neurodifuso Adaptativo, evadiendo así posterior optimización. Finalmente se simularon 10000 pacientes para ser clasificados por el sistema, los resultados se compararon contra un sistema experto. La clasificación resultante fue consistente con la del sistema experto por lo que esta implementación ahorra tiempo y dinero al sistema de salud al proporcionar tratamiento de especialidad solo en casos necesarios.

Finalmente, en 2020, Pradini, Previana y Bachtiar [7], implementan un sistema basado en el método de inferencia de Tsukamoto para calcular el riesgo de padecimiento de diabetes con muy poca información de los pacientes, el corpus utilizado consta solamente de 2 pacientes voluntarios, los datos proporcionados son edad, IMC y presión sanguínea. Un experto diseña funciones de membresía triangulares que posteriormente son optimizadas por el algoritmo de Enjambre de Partículas, además, proporcionó 6 reglas para el control del sistema. La eficiencia se obtiene calculando el error cuadrático medio respecto al porcentaje de riesgo predicho por un estudio especializado, un error de 0.012% se obtiene después de la optimización y se compara con el 25.9% de error obtenido por el sistema sin optimización. Los autores no descartan la posibilidad de utilizar otros corpus disponibles en línea para continuar con el desarrollo y refinamiento del sistema.

3. Materiales y métodos

A continuación, se revisa brevemente el marco teórico asociado a esta investigación, así como la descripción del sistema difuso implementado.

3.1. Lógica Difusa

La lógica tradicional nos orienta al uso de dos valores al momento de definir la pertenencia de los objetos hacia un grupo, sin embargo, este enfoque no necesariamente describe la realidad que se presenta. Para reducir las fallas derivadas de la aproximación clásica, se introduce el concepto de conjunto difuso propuesto por Zadeh en 1965 [8]. Un conjunto difuso se entiende como un conjunto de pares ordenados, cada dupla está formada por un elemento y su valor de membresía en el conjunto. El valor de membresía de un elemento 𝑥 en el conjunto 𝐴 está dado por llamada función de membresía, el grado de pertenencia sólo puede estar en el intervalo [0,1]. Las funciones más usadas son las triangulares, pero también pueden encontrarse tipo gamma, lineales, sigmoidales, etc.

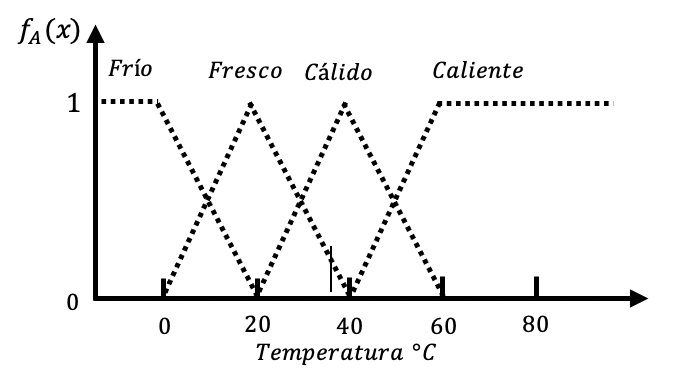

Como ejemplo, considere el mapeo da las funciones de membresía para la temperatura en grados centígrados, donde las variables lingüísticas o categorías a usar son frío, fresco, cálido y caliente, y el universo discurso está definido entre 0º y 80º, la Figura 1, muestra el resultado de definir estas variables lingüísticas, considere que la selección de las formas de las funciones de membresía, así como su posicionamiento en el universo discurso pueden variar en función del propósito [9].

Los humanos nos comunicamos en nuestro propio lenguaje natural con términos simples que pueden implicar ambigüedad, por ejemplo, términos como muy lento, joven, o muy feo. A partir de esta manera de hablar se generan modelos lingüísticos usando sistemas difusos, un sistema de este tipo para cualquier propósito incluye un módulo de Sistema de Inferencia Difuso (FIS). De manera sistemática, un FIS es una manera de mapear el espacio de entrada al espacio de salida a través de la toma de decisiones basadas en reglas. En el campo de la inteligencia artificial, existen diversas formas de representar el conocimiento, sin embargo, la más común es encapsularlo en expresiones del tipo SI premisa (antecedente), ENTONCES conclusión (consecuente)[9], este modelo recibe el nombre de regla SI-ENTONCES, y está asociado al pensamiento deductivo partiendo de un hecho o premisa para inferir un segundo hecho, también llamado concusión.

Los sistemas basados en reglas son especialmente útiles al modelar sistemas complejos apegados a la manera humana del pensamiento, pues hacen uso de variables lingüísticas, antecedentes, consecuentes y conectivos lógicos para establecer las reglas del sistema. Los conectivos lógicos “y” y “o”, tienen el propósito de establecer restricciones, además, estas reglas, así como las funciones de membresía asociadas, se encuentran almacenadas en la base de conocimiento [10], que es legible por la máquina, misma que es capaz de obtener razonamiento deductivo automático a partir de ella, el conocimiento almacenado debe ser lógico y consistente con la realidad y puede ser expandido.

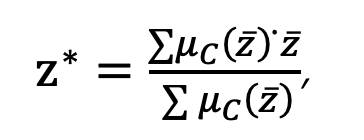

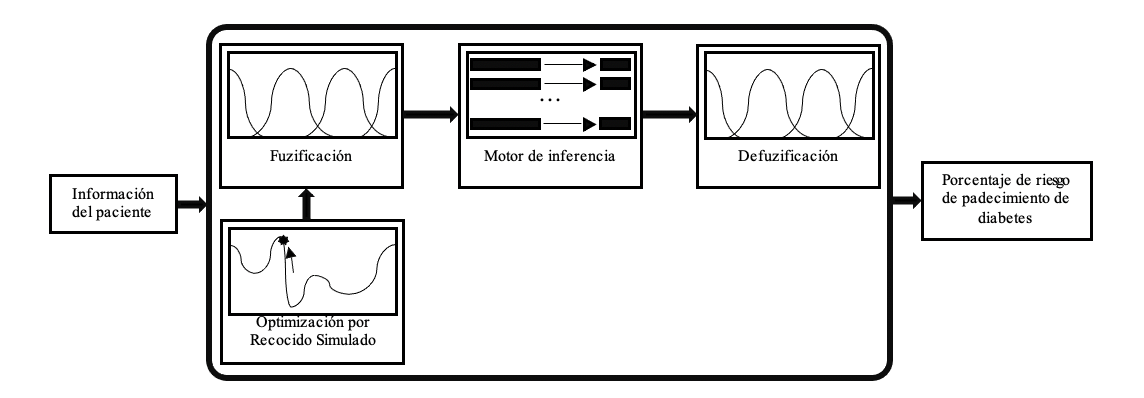

Un FIS se compone fundamentalmente de tres etapas [9, 10], la primera es la fuzificación, proceso en el que una cantidad certera es convertida a una cantidad difusa, esto se logra obtenido el valor de membresía del dato de entrada en cada una de las variables lingüísticas, es decir, la conversión de una cantidad precisa a una cantidad difusa, posteriormente se hace uso del motor de inferencia, el cual aplica las reglas de implicación SI-ENTONCES para transformar las variables de entrada fuzificadas en una variable difusa de salida haciendo uso de la base de conocimiento, finalmente se lleva a cabo el proceso de defuzificación, pues en la mayoría de las ocasiones, la salida difusa de un sistema debe ser cuantificada como un escalar único o un valor del universo discurso, el procedimiento más común es hacer el cálculo del promedio ponderado pues es de los métodos computacionalmente más eficientes, aunque solo es aplicable para funciones de membresía de salida que sean simétricas, la expresión para el promedio ponderado es:

(1)

(1)La estructura básica de un Sistema de Inferencia Difuso se muestra en la Figura 2.

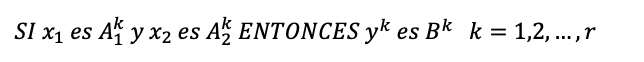

El método de inferencia más utilizado tanto en la literatura como en la implementación es el método de Mamdani [9], desarrollado por Mamdani y Assilian en 1975, considera varias reglas con varias variables de entrada y una única variable salida. Como ejemplo, se muestra una colección de Importar imagen reglas de inferencia compuestas de 2 variables de entrada , en el antecedente con un único consecuente:

(2)

(2)donde y son conjuntos difusos que representan el antecedente de la k-ésima regla y es el conjunto difuso que representa al k-ésimo consecuente.

Generalmente se utiliza el proceso mínimo-máximo: Para cada uno de los hechos es y es , se aplica el operador de intersección usando el mínimo de los valores de membresía, este será el valor al que se corte la función de salida , este proceso se repite para todas las Importar imagen reglas del sistema. Finalmente, se obtiene la unión con el máximo de todas las funciones de membresía de los consecuentes , este último proceso recibe el nombre de agregación, pues integra todos los valores a la salida de todas las reglas del sistema. Esta técnica se muestra gráficamente en la Figura 3 y puede expresar como:

(3)

(3)

3.2. Recocido Simulado

Los problemas de optimización tienen una amplia cantidad de soluciones potenciales, el objetivo es encontrar los valores adecuados para las variables de decisión involucradas que permitan obtener el máximo o mínimo valor de una función objetivo, diversos problemas poseen una complejidad algorítmica elevada, aun así, pueden solucionarse de manera eficiente. Para ello, se generan procedimientos que puedan encontrar soluciones aceptables sin que necesariamente sean óptimas, un método exacto siempre generará una solución óptima, pero un método heurístico simplemente busca aportar una solución aproximada al problema que en muchas ocasiones puede no ser la óptima.

Las técnicas heurísticas suelen utilizarse cuando no existe ningún método exacto para encontrar la solución al problema, o bien, existe un método exacto, pero computacionalmente es muy costoso, también se aplican cuando el problema no exige de la solución exacta o si se tienen condiciones difíciles de modelar. Los métodos heurísticos son utilizados en una amplia gama de problemas y algunas de sus ventajas son: tener una solución potencialmente buena desde el punto de partida, poder usarse para solucionar solamente una parte del problema y ser muy sencillos de comprender [11].

El Recocido Simulado fue diseñado para problemas de optimización combinatoria para ruteo y agente viajero (TSP) en 1983 por Kirkpatrick, Gellat y Vecchi. Yang [12], lo describe como un algoritmo que trata de imitar el proceso de recocido de los materiales metálicos. Al enfriarlos hasta un estado de energía mínima, se obtienen cristales de mayor tamaño que reducen los defectos de sus estructuras. El recocido es un procedimiento que requiere sumo cuidado de la temperatura, tanto al calentar el metal como en su ritmo de enfriamiento, una de sus ventajas es la capacidad de evadir mínimos locales y poder converger al óptimo local bajo condiciones apropiadas, es decir, si se utilizan buenos pasos aleatorios con un ritmo adecuado de enfriamiento.

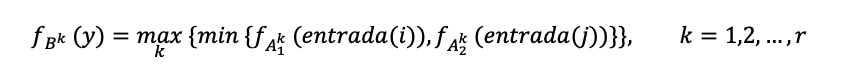

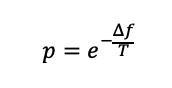

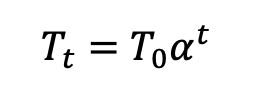

La forma de operación del recocido consiste en aplicar de manera iterativa una búsqueda aleatoria y aceptar tanto puntos que mejoren la solución como algunos otros que no lo hagan, cualquier movimiento que mejore la solución es aceptado de manera automática, sin embargo, cualquier punto que no la mejore, puede ser aceptado con una probabilidad , que se le conoce como probabilidad de transición, dada por:

(4)

(4)Donde es la diferencia entre la solución actual y la mejor de la función objetivo hasta ese momento y es la temperatura actual.

Al aceptar en automático una mejor solución, se está explotando la región actual en búsqueda de un óptimo local, mientras que al aceptar con una baja probabilidad una solución que no mejore el resultado, se lleva a cabo una tarea de exploración buscando un óptimo global. A medida que decrece la temperatura, la probabilidad de diversificar las soluciones tiende a 0, por lo que se intensifica la búsqueda local. El sistema se enfría de manera paulatina desde una temperatura elevada hasta un enfriamiento suficiente, mismo que normalmente se programa de manera geométrica, en este proceso se establece una temperatura inicial , además de un factor de conservación de temperatura tal que , en cada iteración la temperatura se actualiza mediante la Ecuación (5):

(5)

(5)Esta técnica evita que se alcance pues esto solo ocurre cuando sin necesidad de establecer una cantidad de iteraciones. El lento descenso de la temperatura requiere de múltiples repeticiones para generar soluciones aceptables, pues una cantidad pequeña hará que el sistema no converja al óptimo global, además, una cantidad demasiado grande consumirá tiempo excesivo de cómputo, problema que se agrava al trabajar en demasiadas dimensiones. El algoritmo general del Recocido Simulado se muestra en la Figura 4.

3.3. Prueba de FINDRISC

El Finnish Diabetes Risk Score (FINDRISC), es un instrumento de cribaje utilizado para valorar el riesgo de un individuo de desarrollar diabetes tipo 2 dentro de los próximos 10 años, es ampliamente aplicado alrededor del mundo por su simpleza de uso al basarse en un cuestionario de fácil aplicación. La prueba de FINDRISC fue presentada en el año 2003 por Lindström y Tuomilehto [13], con el objetivo de disponer de una herramienta no invasiva y de fácil aplicación en unidades de medicina familiar para medir el riesgo de padecimiento de diabetes mellitus tipo 2 para personas de Finlandia.

El estudio se basa en los estudios FINRISK que originalmente monitoreaban a pacientes durante 10 años en el desarrollo y tratamiento de diabetes si es que resultaban afectados. A partir de 4746 individuos de prueba, se obtuvieron datos descriptivos que no requieran estudios especiales de laboratorio, además, se incluyen preguntas de carácter binario, posteriormente se aplicó regresión logística determinando los coeficientes que se utilizan para el cálculo de la probabilidad de padecimiento de diabetes. El producto fue un modelo 7 preguntas donde se calcula el riesgo mediante una función logística, sin embargo, este procedimiento resultaría inadecuado para aplicarse en consultorios, por lo que se determinó un sistema de puntuación asignada a cada reactivo en dependencia de la respuesta, se tiene un máximo de 20 puntos y el resultado de la prueba es estrictamente categórico, por lo que, sin importar el valor específico de un dato, si se encuentra en algún intervalo, se usará la misma puntuación de toda la categoría, lo que impide establecer un porcentaje de riesgo totalmente personalizado. El modelo fue validado con una sensibilidad y especificidad de 0.78 y 0.77 para el grupo original FINRISK y con un segundo grupo que obtiene 0.81 y 0.76 respectivamente.

Los autores indican que se puede integrar una pregunta sobre historial familiar de diabetes, sin embargo, no dispone del escalar requerido para el cálculo de la función logística y solamente se indica la puntuación para el reactivo. La Guía de Práctica Clínica del Instituto Mexicano del Seguro Social (IMSS) [14], sí toma en cuenta la pregunta sobre historial familiar además de agregar una categoría adicional para la edad, esto establece una puntuación máxima de 26 puntos, el cuestionario que se aplica en el IMSS se muestra en la Tabla 1.

| Variable | Puntaje |

| EDAD <45 | 0 |

| EDAD 45-54 | 2 |

| EDAD 55-64 | 3 |

| EDAD >64 | 4 |

| IMC <25 | 0 |

| IMC 25-30 | 1 |

| IMC >30 | 3 |

| CIRCUNF. ABDOMEN MASCULINO <94 FEMENINO <80 | 0 |

| CIRCUNF. ABDOMEN MASCULINO 94-101 FEMENINO 80-87 | 3 |

| CIRCUNF. ABDOMEN MASCULINO >101 FEMENINO >87 | 4 |

| ¿Ha sido tratado con medicamento para la presión arterial alguna vez? | 2 |

| ¿Le han detectado niveles altos de glucosa alguna vez? | 5 |

| ¿Realiza menos de 4 horas de actividad física a la semana? | 2 |

| ¿Su dieta carece de frutas, vegetales o bayas? | 1 |

| ¿Ha habido algún diagnóstico de DM en su familia? NO | 0 |

| ¿Ha habido algún diagnóstico de DM en su familia? SÍ: Abuelos, tíos o primos hermanos | 3 |

| ¿Ha habido algún diagnóstico de DM en su familia? SÍ: Padres, hermano o hijos | 5 |

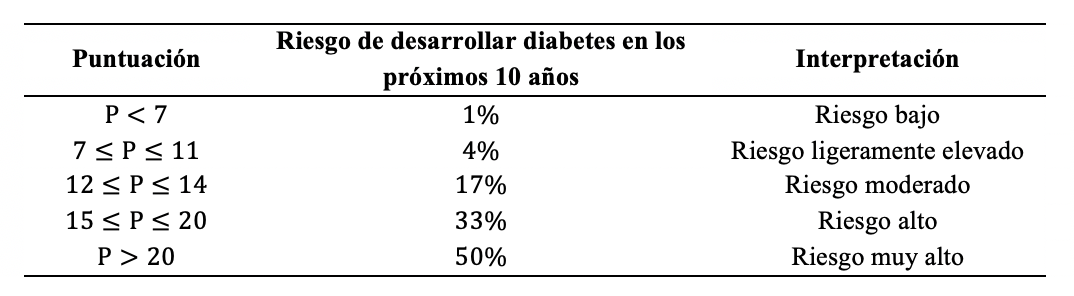

El riesgo de padecimiento de diabetes tipo 2 según la puntuación del cuestionario se muestra en la Tabla 2:

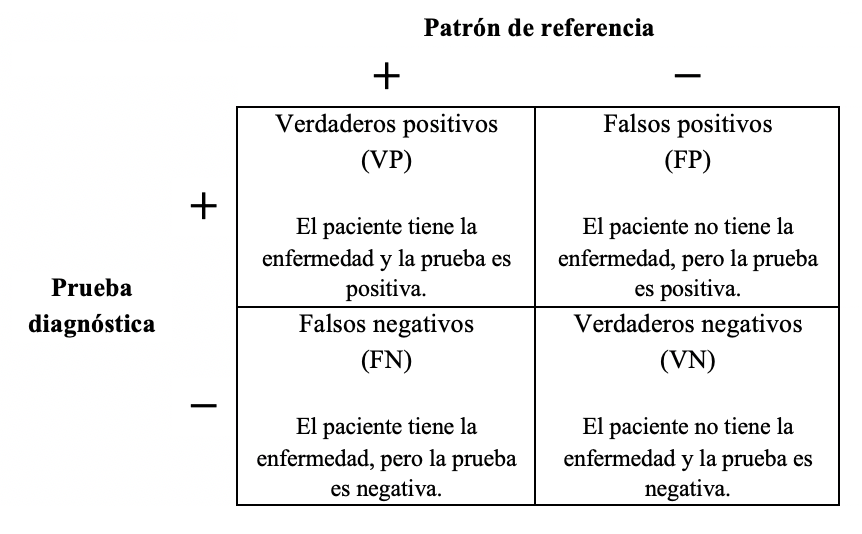

3.4. Herramientas para la interpretación de estudios de exactitud diagnóstica

Para describir la utilidad de los sistemas o pruebas para diagnóstico de enfermedades se toma en cuenta la tabla de contingencia [15, 16], ver Figura 5.

De donde se obtienen las siguientes métricas:

Sensibilidad: Proporción de individuos correctamente diagnosticados con la enfermedad por la prueba diagnóstica respecto a un estándar de referencia.

Especificidad: Proporción de individuos correctamente diagnosticados con ausencia de la enfermedad por la prueba diagnóstica respecto a un estándar de referencia.

Valor predictivo positivo (VPP): Probabilidad condicional de que el paciente tenga la enfermedad dado que la prueba resultó positiva, es decir, la proporción de pacientes con prueba diagnóstica positiva que realmente padecen la enfermedad.

Valor predictivo negativo (VPN): Probabilidad condicional de que el paciente no tenga la enfermedad dado que la prueba resultó negativa, es decir, la proporción de pacientes con prueba diagnóstica negativa y que no padece la enfermedad.

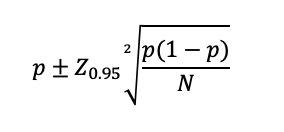

Los valores predictivos son estimaciones de la probabilidad de que la prueba diagnóstica entregue un resultado correcto dado que esta resulte negativa o positiva, según sea el caso. Puesto que las proporciones mencionadas son estimaciones obtenidas con estudios llevados a cabo con muestras de población, están sujetas a variabilidad, así, para poder utilizarlas adecuadamente es necesario calcular sus intervalos de confianza, en este caso, se elige el intervalo de confianza al 95% (IC 95%). En otras palabras, se determinará el intervalo en el que el 95% de posteriores pruebas del sistema concentraran sus valores de las métricas mencionadas [16]. Se utiliza un método estándar a partir de la proporción binomial [15]:

(10)

(10) Donde es la proporción a la que se le está estimando el intervalo de confianza, el tamaño muestral y se obtiene a partir de las tablas de la función normal, para una campana de dos colas, =1.96. Cabe resaltar que los intervalos de confianza deben ser tomados en cuenta al momento de analizar la validez de la prueba, un tamaño muestral demasiado pequeño, menor que 30 corre el riesgo de mostrar intervalos de confianza sumamente amplios, dejando limitada la validez de la prueba. El tamaño óptimo del intervalo no se encuentra escrito por ninguna regla, queda sujeto al tipo de estudio y las condiciones relacionadas [15, 16]. Se agrega, además, el concepto de exactitud que indica cuánto un resultado que se aleja del valor de referencia, mientras más cercano al valor real, mayor exactitud de los resultados.

3.5. Datos utilizados

La investigación de Mendiola et al. en el 2017 [3] tuvo por objetivo evaluar el desempeño de la prueba de FINDRISC, con pacientes libres de diabetes tipo 2 adscritos a la Unidad de Medicina Familiar No. 9 del IMSS de Acapulco, Guerrero. Se seleccionaron de manera aleatoria 295 participantes, 205 femeninos y 90 masculinos para aplicarles el cuestionario, así como tomas orales de glucosa en ayuno para determinar si padecían o no diabetes.

Entre los datos recabados se encuentran edad en años, índice de masa corporal (IMC), medida en centímetros de la circunferencia abdominal redondeada al entero más cercano, además de algunos datos de carácter binario como realización de al menos 30 minutos de actividad física por día, consumo diario de frutas y vegetales, medicación previa para presión arterial elevada, exámenes positivos previos de glucosa alta, así como un reactivo triario donde se pregunta al paciente si tiene parientes cercanos o lejanos con diabetes detectada, con la opción de responder negativamente si no se tienen ningún pariente diagnosticado, mismos datos que requiere la prueba de FINDRISC, también, se registra la puntuación obtenida en la prueba y el resultado categórico, así como el resultado de las pruebas de laboratorio necesarias para el diagnóstico. Posterior a la recaudación de datos, se registró la cantidad de pacientes puntuados con alto y bajo riesgo según la prueba de FINDRISC, y el diagnostico posterior a la consulta después de prueba de glucosa de laboratorio de acuerdo a la American Diabetes Association, que clasifica a los pacientes como glucosa normal <(100mg/dl), prediabetes (100 a 125mg/dl) y diabetes tipo 2 (>125mg/dl), además se clasificó a los pacientes con bajo riesgo a los individuos con 14 puntos o menos en la prueba de FINDRISC, y de alto riesgo a aquellos con 15 o más puntos.

Los resultados mostraron que la prueba de FINDRISC tiene un desempeño adecuado para el tamizaje de diabetes tipo 2 en población mexicana, con sensibilidad mayor a 80%, pacientes con diabetes tipo 2 no diagnosticada, a los que se aplique el cuestionario tendrán 15 puntos o más. Mientras que detecta un gran número de falsos positivos, tiene la capacidad de discriminar a aquellos que no están enfermos. La prueba de FINDRISC resultó ser adecuada y útil como prueba de tamizaje además de ser de fácil uso y no invasiva, los resultados se detallan en la sección 4.

3.6. Sistema implementado

Como se puede apreciar en la Tabla 2, el riesgo de padecimiento de diabetes tipo 2 arrojado por la prueba de FINDRISC, sólo puede adoptar 5 resultados posibles, por lo que todos los pacientes evaluados pertenecerán a alguna de estas categorías, sin embargo, esta clasificación puede no ser la más descriptiva para algunos individuos. Considere los casos de dos personas con puntuaciones en la prueba de FINDRISC de 11 y 12 puntos respectivamente, el primero corresponde a un riesgo del 4%, ligeramente elevado, mientras que el segundo obtiene un riesgo moderado de 17% aun cuando ambos pacientes podrían mostrar características idénticas en todos los reactivos salvo en alguno, por ejemplo, la edad, donde 64 y 65 años arrojan un punto de diferencia al momento de aplicar la prueba. Es por casos como este que se propone la construcción de un sistema que pueda indicar a un paciente su riesgo de padecimiento con un resultado no categórico y que refleje su estado actual, y así, se puedan tomar las medidas requeridas para el cuidado de su salud.

Utilizando los datos de [3], se considera el subconjunto que requiere la prueba de FINDRISC, posteriormente se desarrolló un sistema de lógica difusa basado en el método de inferencia de Mamdani capaz de predecir el riesgo de padecimiento de diabetes de un paciente con base en los datos seleccionados, puesto que las circunferencias abdominales de cada género consideran intervalos distintos, se desarrolló un sistema por cada género. La prueba de FINDRISC otorga una determinada cantidad de puntos en una escala de 0 a 5 a la respuesta de cada pregunta, por lo que se usa cada una de posibilidades como una variable lingüística, esto se muestra en la Tabla 3:

| Puntaje | Variable lingüística |

| 0 | Factor de riesgo muy bajo |

| 1 | Factor de riesgo bajo |

| 2 | Factor de riesgo ligeramente elevado |

| 3 | Factor de riesgo moderado |

| 4 | Factor de riesgo alto |

| 5 | Factor de riesgo muy alto |

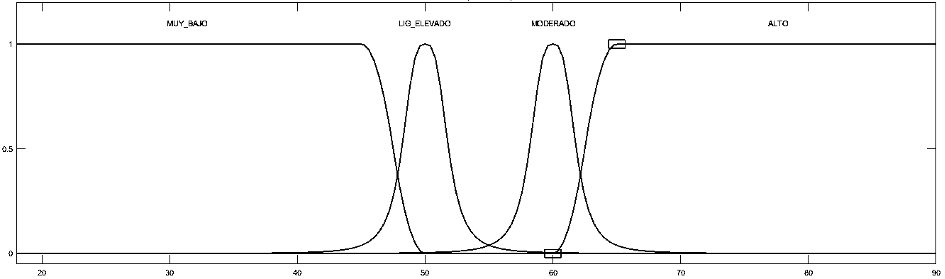

Tenga en cuenta que no todas las variables lingüísticas son utilizadas para cada dato de entrada, pues solamente se utilizan aquellas que estén presentes en el cuestionario de FINDRISC, por ejemplo, considere la variable de entrada edad, de la Tabla 1, se sabe que únicamente se utilizaran las variables lingüísticas Edad de riesgo muy bajo, Edad de riesgo ligeramente elevado, Edad de riesgo moderado y Edad de riesgo alto. El universo discurso comprende edad desde los 18 hasta los 90 años, este intervalo se utiliza para abarcar a casi la totalidad de la población, la Edad de riesgo muy bajo, está descrita por una función en forma de cuyo máximo se encuentra en el valor 45 y su mínimo en el valor de 50, Edad de riesgo ligeramente elevado está representada por una campana generalizada con centro en 50, que es el punto medio del intervalo de edad comprendido por el reactivo de FINDRISC, la anchura de la campana y su pendiente se seleccionaron visualmente, de manera que la función se acercara a su mínimo al llegar a los máximos de las funciones de membresía vecinas, la variable lingüística Edad de riesgo moderado, también es una campana generalizada con centro en 60, donde se aplicaron los mismos criterios para seleccionar el centro, la anchura y la pendiente, finalmente, Edad de riesgo alto se visualiza a través de una función , cuyo máximo se encuentra en 65 y su mínimo en 60, esta configuración se puede apreciar en la Figura 6.

En general, cuando una variable de entrada dispone de más de dos variables lingüísticas, la heurística se encarga de ajustar la anchura y la pendiente de las funciones de membresía centrales, por lo que, para las variables binarias, no se requiere de optimización. Los resultados obtenidos por este sistema se muestran a detalle en la sección 4.

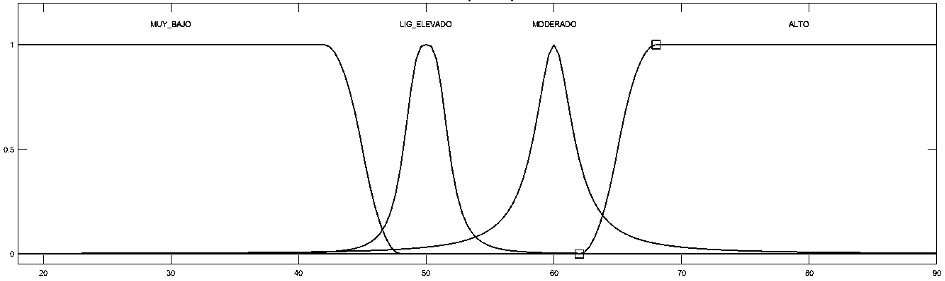

Como se mencionó en la sección 3.2, el recocido acepta soluciones no mejores a altas temperaturas con el objetivo de aprovechar la etapa de exploración en el espacio de soluciones, como consecuencia, se está buscando un óptimo global, sin embargo, este enfoque no es el más adecuado para el problema abordado en esta investigación, pues ya se dispone de una configuración apegada a la teoría, por lo que solamente hace falta refinar estas funciones de membresía para mejorar el resultado, esto es equivalente a explotar la región cercana a esta configuración en búsqueda de un óptimo local, entonces, el recocido ha de ser utilizado con temperaturas bajas y una cantidad considerable de iteraciones. Se optimizó la anchura y la pendiente de 4 funciones de membresía, generando un problema de optimización de 8 dimensiones, el mejor resultado obtenido altera las funciones de membresía de la variable edad como se muestra en la Figura 7 y se discute en la sección 4.

Por otro lado, el motor de inferencia está compuesto por 102 reglas difusas obtenidas analizando cada uno de los individuos dentro de la base de datos, el razonamiento utilizado para esta tarea es explicado a continuación.

Las 6 variables lingüísticas mencionadas con anterioridad son aprovechadas, para cada uno de los 295 casos dentro de la base de datos, se obtiene la puntuación de cada pregunta que dicta la prueba de FINDRISC y su resultado, generando una regla cuyo antecedente se compone de los factores de riesgo contenidos en la base de datos y el consecuente es la salida de la prueba de FINDRISC, como ejemplo considere el caso femenino de la Tabla 4 con riesgo de padecimiento según la prueba de FINDRISC de 4%, es decir Riesgo ligeramente elevado:

| Factor de riesgo | Valor | Puntaje |

| Edad | 55 años | 3 |

| Circunferencia abdominal | 87 cm | 3 |

| Índice de masa corporal | 26.75 | 1 |

| Falta de actividad física | Verdadero | 2 |

| Bajo consumo de frutas y verduras | Verdadero | 1 |

| Tratamiento previo para presión arterial | Verdadero | 2 |

| Estudio previo de glucosa alta | Falso | 0 |

| Historial familiar de padecimiento de diabetes | Falso | 0 |

Cuya regla difusa es:

SI edad es de riesgo moderado y circunferencia abdominal es de riesgo moderado y índice de masa corporal es de riesgo bajo y actividad física es de riesgo ligeramente elevado y consumo de frutas y verduras es de riesgo bajo y tratamiento para presión arterial es de riesgo ligeramente elevado y estudio previo de glucosa es de riesgo muy bajo e historial familiar de diabetes es de riesgo muy bajo, ENTONCES riesgo de padecimiento es ligeramente elevado.

Si un antecedente ya existe en el sistema, el paciente es omitido. Los sistemas de ambos géneros comparten las reglas difusas. La implementación de la optimización se llevó a cabo en MATLAB R2021a, el diseño del sistema difuso y la evaluación se realizó con la extensión Fuzzy Logic Designer de MATLAB. El esquema general del sistema puede visualizarse en la Figura 8.

4. Resultados

Aquí se registran los resultados obtenidos por el sistema difuso implementado optimizado y sin optimizar, y se contrastan con los obtenidos por Mendiola et al.[3]. Se ejecutó el algoritmo de optimización 40 veces por cada sistema difuso y se utilizó el mejor resultado para la comparación, las Tablas 5 y 6 muestran los resultados obtenidos por los sistemas difusos sin optimizar para pacientes femeninos y masculinos respectivamente, mientras que las Tablas 7 y 8 hacen referencia a los sistemas optimizados.

| VPN | VPP | Sensibilidad | Especificidad | |

| Resultado | 0.9562 | 0.3382 | 0.7931 | 0.7443 |

| Inicio del IC 95% | 0.9219 | 0.2258 | 0.6457 | 0.6799 |

| Fin del IC 95% | 0.9905 | 0.4507 | 0.9405 | 0.8088 |

| Tamaño del IC 95% | 0.0685 | 0.2249 | 0.2949 | 0.1289 |

| VPN | VPP | Sensibilidad | Especificidad | |

| Resultado | 0.9464 | 0.2353 | 0.7273 | 0.6709 |

| Inicio del IC 95% | 0.8875 | 0.0927 | 0.4641 | 0.5673 |

| Fin del IC 95% | 1.0054 | 0.3779 | 0.9905 | 0.7745 |

| Tamaño del IC 95% | 0.1180 | 0.2852 | 0.5264 | 0.2072 |

| VPN | VPP | Sensibilidad | Especificidad | |

| Resultado | 0.9687 | 0.3246 | 0.8620 | 0.7045 |

| Inicio del IC 95% | 0.9386 | 0.2200 | 0.7365 | 0.6371 |

| Fin del IC 95% | 0.9988 | 0.4292 | 0.9875 | 0.7719 |

| Tamaño del IC 95% | 0.0602 | 0.2092 | 0.2510 | 0.1348 |

| VPN | VPP | Sensibilidad | Especificidad | |

| Resultado | 0.9814 | 0.2777 | 0.9090 | 0.6709 |

| Inicio del IC 95% | 0.9455 | 0.1314 | 0.7392 | 0.5672 |

| Fin del IC 95% | 1.0000 | 0.4240 | 1.0789 | 0.7745 |

| Tamaño del IC 95% | 0.0545 | 0.2926 | 0.3397 | 0.2073 |

Se comparan los resultados de los sistemas difusos optimizados combinados de ambos géneros con los obtenidos por el estudio de Mendiola et al. [3], los resultados de la prueba de FINDRSIC se toman directamente de dicha publicación, la comparación se puede observar en la Tabla 9.

| VPN FINDRISC | VPN Difuso | VPP FINDRISC | VPP Difuso | Sensibilidad FINDRISC | Sensibilidad Difuso | Especificidad FINDRISC | Especificidad Difuso | |

| Resultado | 0.9640 | 0.9725 | 0.2244 | 0.3097 | 0.8750 | 0.8750 | 0.5255 | 0.6941 |

| Inicio del IC 95% | 0.9181 | 0.9488 | 0.1615 | 0.2245 | 0.732 | 0.7725 | 0.4623 | 0.6376 |

| Fin del IC 95% | 0.9882 | 0.9963 | 0.2908 | 0.3950 | 0.9591 | 0.9775 | 0.5881 | 0.7507 |

| Tamaño del IC 95% | 0.0701 | 0.0475 | 0.1293 | 0.1705 | 0.2271 | 0.2050 | 0.1258 | 0.1131 |

5. Conclusiones

Los sistemas difusos sin optimizar muestran respecto a los sistemas optimizados, valores predictivos negativos más bajos, y en general, valor predictivo positivo mayor para género femenino pero menor para masculino, además de mostrar una sensibilidad de la prueba menor, pero con especificidades iguales o mayores, también se observa que los tamaños de los intervalos de confianza son en general menores. Una especificidad menor en los sistemas optimizados no significa que el sistema este obteniendo peores resultados, la sensibilidad considera la validez de la prueba entre individuos enfermos, mientras que la especificidad considera la validez entre individuos sanos, cuando se aplican pruebas de detección para padecimientos que no necesariamente muestren síntomas, son de mayor interés los modelos muy sensibles para reducir la cantidad de falsos negativos, por lo que esta métrica resulta ser la más importante para nuestro propósito, sin embargo, no debe dejarse de lado la especificidad, pues al momento de confirmar un diagnóstico se requiere una especificidad alta para evadir los falsos positivos, entonces, se debe priorizar la búsqueda de la máxima sensibilidad sin descuidar los valores de especificidad [16].

Observando los sistemas optimizados, para ambos géneros la proporción de pacientes catalogados como alto riesgo que realmente padecen la enfermedad es alta cercana al 100%, mientras que la proporción de pacientes catalogados como bajo riesgo y que no padece la enfermedad es baja, además, la sensibilidad es aceptable en ambos casos, por encima del 85% por lo que detecta de manera adecuada los casos verdaderos positivos, considerando la especificidad, esta se encuentra en márgenes aceptables, mayores al 67%, indicado de que se detecta de manera adecuada poco más de dos terceras partes de los verdaderos negativos.

A partir de este punto, las observaciones se centran en la Tabla 9, es notable que el valor predictivo positivo entregado por el sistema difuso es ligeramente superior con un IC95% de menor tamaño, el valor predictivo positivo es casi 0.08 unidades mayor, al costo de tener un IC95% ligeramente más grande. La sensibilidad es el parámetro más importante en los estudios de este tipo, ambos métodos entregan la misma eficacia de 87.5%, sin embargo, el sistema difuso cuenta con un IC95% ligeramente reducido respecto al de FINDRISC, finalmente, la especificidad es superior en el sistema difuso alcanzando casi un 70% a un lado del casi 53% de la prueba de FINDRISC, además, el IC95% es ligeramente menor, aunque una diferencia de esta magnitud no es particularmente significativa.

Si bien el criterio de sensibilidad arrojada por el sistema difuso es idéntico al obtenido por la prueba de FINDRISC y la mejora en el intervalo de confianza puede no ser significativa, el incremento en la especificidad sugiere que el sistema difuso es capaz de detectar en buena medida a los pacientes no enfermos y asignarles riesgos de padecimiento apegados a la realidad con base en la descripción del paciente, es decir, asignarles riesgos bajos a pacientes sin diabetes y con estilos de vida saludables, mientras que asigna riesgos altos a personas con prediabetes o diabetes y de estilos de vida poco saludables.

Además, los valores predictivos positivo y negativo en el sistema difuso muestran mejoras significativas por lo que el uso del sistema difuso como auxiliar en materia de prevención de diabetes mellitus 2 pude ser de gran utilidad al brindar resultados que describen adecuadamente la realidad comparados contra un estándar de oro. Se considera la posibilidad de colocar el sistema a través de una aplicación web o de escritorio que permita a cualquier persona conocer el riesgo de padecimiento con valor no categórico, y de ser necesario, dirigirse oportunamente con un especialista para la realización de estudios y tratamiento especializado.

6. Agradecimientos

Los autores desean agradecer la invaluable ayuda de la Dra. Indira Rocío Mendiola Pastrana por proporcionar la base de datos utilizada en este trabajo, así como la del Dr. José Gustavo López y López por fungir como experto en temas de diabetes. También agradecer ampliamente a la Benemérita Universidad Autónoma de Puebla por gestionar la licencia para uso de MATLAB R2021a.

7. Referencias

[1] Organización Mundial de la Salud. (2016). Informe Mundial Sobre la Diabetes. Recuperado de: http://apps.who.int/iris/bitstream/handle/10665/254649/9789243565255-spa.pdf

[2] Instituto Nacional de Salud Pública. (2018). Encuesta Nacional de Salud y Nutrición. Recuperado de: http://ensanut.insp.mx/encuestas/ensanut2018/doctos/informes/ensanut_2018_presentacion_resultados.pdf

[3] Mendiola Pastrana, I. R., Urbina Aranda, I. I., Muñoz Simón, A. E., Juanico Morales, G., López Ortiz, G. (2017). Evaluación del desempeño del Finnish Diabetes Risk Score (FINDRSIC) como prueba de tamizaje para diabetes mellitus tipo 2. Atención Familiar, 25 (1), 22-26. doi: http://dx.doi.org/10.22201/facmed.14058871p.2018.1.62925

[4] Reddy Gadekallu, T., Khare, N. (2017). Cuckoo Search Optimized Reduction and Fuzzy Logic Classifier for Heart Disease and Diabetes Prediction. International Journal of Fuzzy System Applications (IJFSA), 6 (2), 25-42. doi: http://dx.doi.org/10.4018/IJFSA.2017040102

[5] Sahu, N., Verma, T., Reddy, G. T. (2017). Diabetes classification using fuzzy logic and adaptive cuckoo search optimization techniques. International Journal on Future Revolution in Computer Science & Communication Engineering (IJFRCSCE), 3 (9), 252-255. Recuperado de: http://www.ijfrcsce.org/index.php/ijfrcsce/article/view/253/253

[6] Bressan, G. M., Flamia Azevedo, B. C., Molina de Souza, R. (2020). A Fuzzy Approach for Diabetes Mellitus Type 2 Classification. Brazilian Archives of Biology and Technology, 63, 1-11. doi: https://doi.org/10.1590/1678-4324-2020180742

[7] Pradini, R. S., Previana, C. N., Bachtiar, F. A. (2020). Fuzzy Tsukamoto Membership Function Optimization Using PSO to Predict Diabetes Mellitus Risk Level. Trabajo presentado en 5th International Conference on Sustainable Information Engineering and Technology, New York, United States. doi: https://doi.org/10.1145/3427423.3427451

[8] Zadeh, L. A. (1965). Fuzzy Sets. Information and Control, 8 (3), 338-353. doi: https://doi.org/10.1016/S0019-9958(65)90241-X

[9] Roos, T. J. (2010). Fuzzy Logic with Engineering Applications (3rd Ed.). EUA: John Wiley & Sons.

[10] Jain, V., Raheja, S. (2015). Improving the Prediction Rate of Diabetes using Fuzzy Expert System. International Journal of Information Technology and Computer Science (IJITCS), 7 (10), 84-91. doi: https://doi.org/10.5815/ijitcs.2015.10.10

[11] Martí, R. (2021). Procedimientos Metaheurísticos en Optimización Combinatoria. Departamento de Estadística e Investigación Operativa, Facultad de Matemáticas, Universidad de Valencia. Recuperado de https://www.uv.es/rmarti/paper/docs/heur1.pdf

[12] Yang, X. S. (2014). Nature-Inspired Optimization Algorithms (1st Ed.). EUA: Elsevier. doi: https://doi.org/10.1016/C2013-0-01368-0

[13] Lindström, J., Tuomilehto, J. (2003). The diabetes risk score: a practical tool to predict type 2 diabetes risk. Diabetes Care, 26 (3), 725-731. doi: https://doi.org/10.2337/diacare.26.3.725

[14] Instituto Mexicano del Seguro Social. (2018). Diagnóstico y Tratamiento Farmacológico de la Diabetes Mellitus Tipo 2 en el Primer Nivel de Atención. Catálogo Maestro de Guías de Práctica Clínica. Recuperado de: http://www.imss.gob.mx/sites/all/statics/guiasclinicas/718GER.pdf

[15] Bravo-Grau, S., Cruz, J. P. (2015). Estudios de exactitud diagnóstica: Herramientas para su Interpretación. Revista Chilena de Radiología, 21 (4), 158-164. doi: https://doi.org/10.4067/S0717-93082015000400007

[16] Ochoa Sangrador, C., Orejas, G. (1999). Epidemiología y metodología científica aplicada a la pediatría (IV): Pruebas diagnósticas. Anales Españoles de Pediatría, 50 (3), 301-314. Recuperado de: https://www.aeped.es/anales/50/3/epidemiologia-y-metodologia-cientifica-aplicada-pediatria-iv-pr