INTRODUCCIÓN

Las TIC han ejercido una notoria influencia en todos los ámbitos de la sociedad, a tal punto, que su adopción y uso se han convertido en una necesidad social casi tan importante como saber leer o escribir. En la actualidad, todas las actividades cotidianas del ser humano están mediadas por herramientas y procesos tecnológicos y las tendencias apuntan a que esa mediación será cada vez mayor. Solo hay que mirar procesos tales como: comunicación, dinámicas de trabajo, interacciones sociales, trámites legales, bancarios, entre otros, que antes se realizaban de forma manual; hoy se han automatizado a través de plataformas tecnológicas (Cruzate & Graells, 2001).

Para Villamil (2012), los vertiginosos cambios tecnológicos y científicos que afronta nuestra sociedad exige el desarrollo de nuevas competencias por parte del ser humano, para adaptarse y utilizar las nuevas tecnologías en pro de la satisfacción de sus necesidades cotidianas. Una de esas competencias son las digitales, las cuales podríamos definir como la integración de conocimientos, habilidades y aptitudes en el campo de la informática y telemática, para el desempeño de tareas en contextos específicos. Estas nuevas competencias se han convertido en requerimientos transversales en todos los aspectos y escenarios de nuestra sociedad, a tal punto que quienes no desarrollen dichas competencias son considerados como analfabetas digitales.

Si bien el término genérico de ‘competencia’ o su connotación es antiguo, el de ‘competencia digital’ está directamente relacionado con el auge de las tecnologías de la información y las comunicaciones y su uso extendido en diferentes escenarios de la sociedad. A través de una revisión bibliográfica, se encontró que las primeras referencias al término de competencia digital se da en el año 1997, en donde la Organización para la Cooperación y el Desarrollo Económico (OCDE), a través del proyecto denominado DeSeCo (Definition and Selection of Competencies), define a la competencia digital como el uso seguro y crítico de las tecnologías de la sociedad de la información (Pech & Prieto, 2015). Asimismo, Ferreiro (2011) define las competencias digitales como las habilidades para usar recursos apropiados para el tratamiento de la información y la solución de problemas a través del uso crítico y responsable de las Tecnologías de la Información y las Comunicaciones, TIC. Con la importancia que tomó el término de ‘competencias digitales’ en los años siguientes, a nivel internacional encontramos varios referentes de iniciativas que buscan medir o certificar el grado de dichas competencias, las cuales exponen Pech & Prieto (2015) en su trabajo titulado: La medición de la competencia digital e informacional.

En el año 2000, en Francia se implementó un sistema para medir y certificar las competencias en informática e Internet, C2i (Certificado en Informática e Internet) y cuatro años más tarde se implementó el C2i nivel 2 especializado, el cual estaba dirigido a profesores. Esta certificación buscaba verificar y certificar las competencias relacionadas con el uso de recursos tecnológicos, el trabajo en equipo y en red (Université de Limoges, 2000). Por otro lado, en Estados Unidos, el Framework for Information Literacy in Higher Education y el Information Literacy Competency Standards for Higher Education (ILSHE), se presenta como un conjunto de documentos y estándares sobre la competencia informacional y la fijación de indicadores para su medición (Association of College and Research Libraries, 2000).

Otra de las iniciativas con aproximadamente 20 años de experiencia en la formación, evaluación y certificación de competencias digitales es la organización sin ánimo de lucro ECDL (European Computer Driving License), la cual ha establecido un estándar internacional de habilidades informáticas conocido como ICDL (International Computer Driving License). Por ser una entidad sin ánimo de lucro realiza convenios con comunidades, autoridades locales y regionales de diferentes países, para ofrecer sus programas de certificación que incluyen diagnóstico, capacitación y examen de certificación de competencias (ECDL Foundation, 1997). Finalmente, la referencia más reciente es el proyecto DIGCOMP del Joint Research Centre de la Comisión Europea para la identificación y validación de los componentes claves de la competencia digital (Ferrari, 2013). Basado en este marco existen dos instrumentos de diagnóstico de competencias digitales en dos portales específicos: el primero es Ikanos (Gobierno Vasco, 2015), y el segundo, Andalucía es Digital (Junta de Andalucía, 2010); ambos instrumentos permiten conocer el nivel de competencias digitales en cada una de las dimensiones definidas por el Marco Común Europeo.

En el contexto colombiano, si bien no se ha definido un marco específico de competencias digitales y no se cuenta con instrumentos propios del contexto, se puede resaltar la iniciativa: Ciudadanía Digital, del Ministerio de las Tecnologías de la Información y las Comunicaciones (Ministerio de las TIC, 2017), que desde el año 2017 viene ofreciendo un completo ecosistema para la formación y certificación de competencias digitales a los ciudadanos colombianos mayores de 13 años.

Ante el escenario anteriormente descrito surge el siguiente interrogante: ¿cómo realizar un análisis pertinente de competencias digitales en el contexto colombiano, identificando las dimensiones en las que se presentan las mayores dificultades en población estudiantil de educación media? La respuesta más lógica es la utilización de un instrumento estandarizado y validado que dé legitimidad a los resultados. En este sentido, una primera opción era la adopción de una escala elaborada y validada como resultado de un proceso de investigación previo; dicho instrumento debía cumplir con los criterios: en primera instancia, adaptación al contexto colombiano y a la población objeto de estudio; y en segunda instancia, contar con la suficiente robustez de contenido para abarcar el mayor número de dimensiones de competencias digitales. Como segunda opción se planteó la construcción de una nueva escala, tomando como referente estudios previos, sean o no del contexto específico de la investigación, y para lo cual se hacía necesario un proceso de validación del instrumento que garantizara su fiabilidad y validez (Rodríguez, 2014).

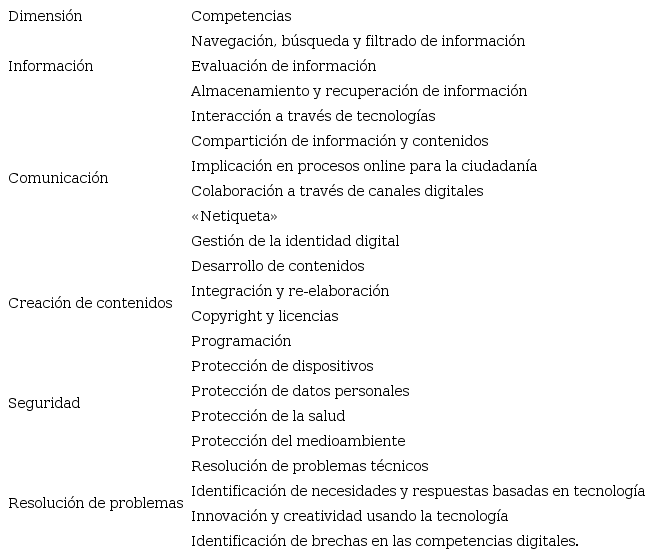

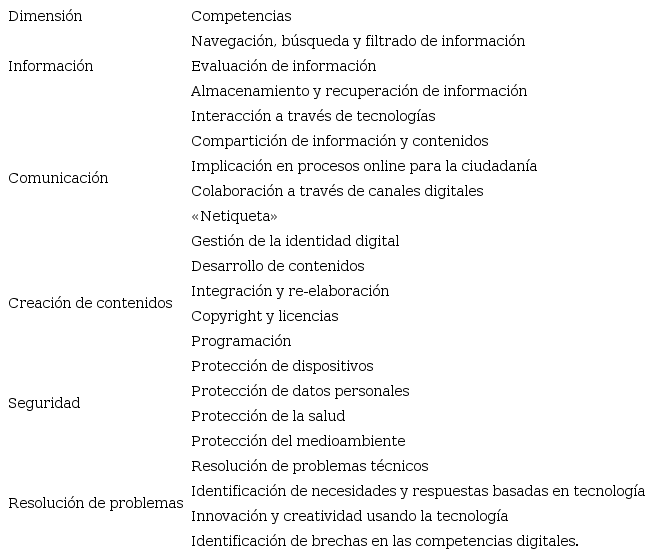

El ejercicio investigativo realizado en el estado del arte de instrumentos de valoración de competencias digitales mostró que las escalas disponibles no cumplían con los criterios ya expuestos, por lo que para efectos del presente trabajo se optó por el diseño de un instrumento, partiendo de las dimensiones de competencias digitales propuestas por el proyecto DIGCOMP del Joint Research Centre de la Comisión Europea, cuyo objetivo es la identificación de los elementos o dimensiones necesarios para ser «digitalmente competente», y se constituye en un marco de referencia más amplio para el estudio de las competencias digitales en el cual se establecen 21 competencias agrupadas en cinco áreas (Ferrari, 2013), como se muestra en la Tabla 1:

Tabla 1.

Dimensiones y competencias Marco Común Europeo

Fuente: elaboración propia.

Fuente: elaboración propia.

|

Dimensión

|

Competencias

|

|

Información

|

Navegación, búsqueda y filtrado de información

|

|

Evaluación de información

|

|

Almacenamiento y recuperación de información

|

|

Comunicación

|

Interacción a través de tecnologías

|

|

Compartición de información y contenidos

|

|

Implicación en procesos online para la ciudadanía

|

|

Colaboración a través de canales digitales

|

|

«Netiqueta»

|

|

Gestión de la identidad digital

|

|

Creación de contenidos

|

Desarrollo de contenidos

|

|

Integración y re-elaboración

|

|

Copyright y licencias

|

|

Programación

|

|

Seguridad

|

Protección de dispositivos

|

|

Protección de datos personales

|

|

Protección de la salud

|

|

Protección del medioambiente

|

|

Resolución de problemas

|

Resolución de problemas técnicos

|

|

Identificación de necesidades y respuestas basadas en tecnología

|

|

Innovación y creatividad usando la tecnología

|

|

Identificación de brechas en las competencias digitales.

|

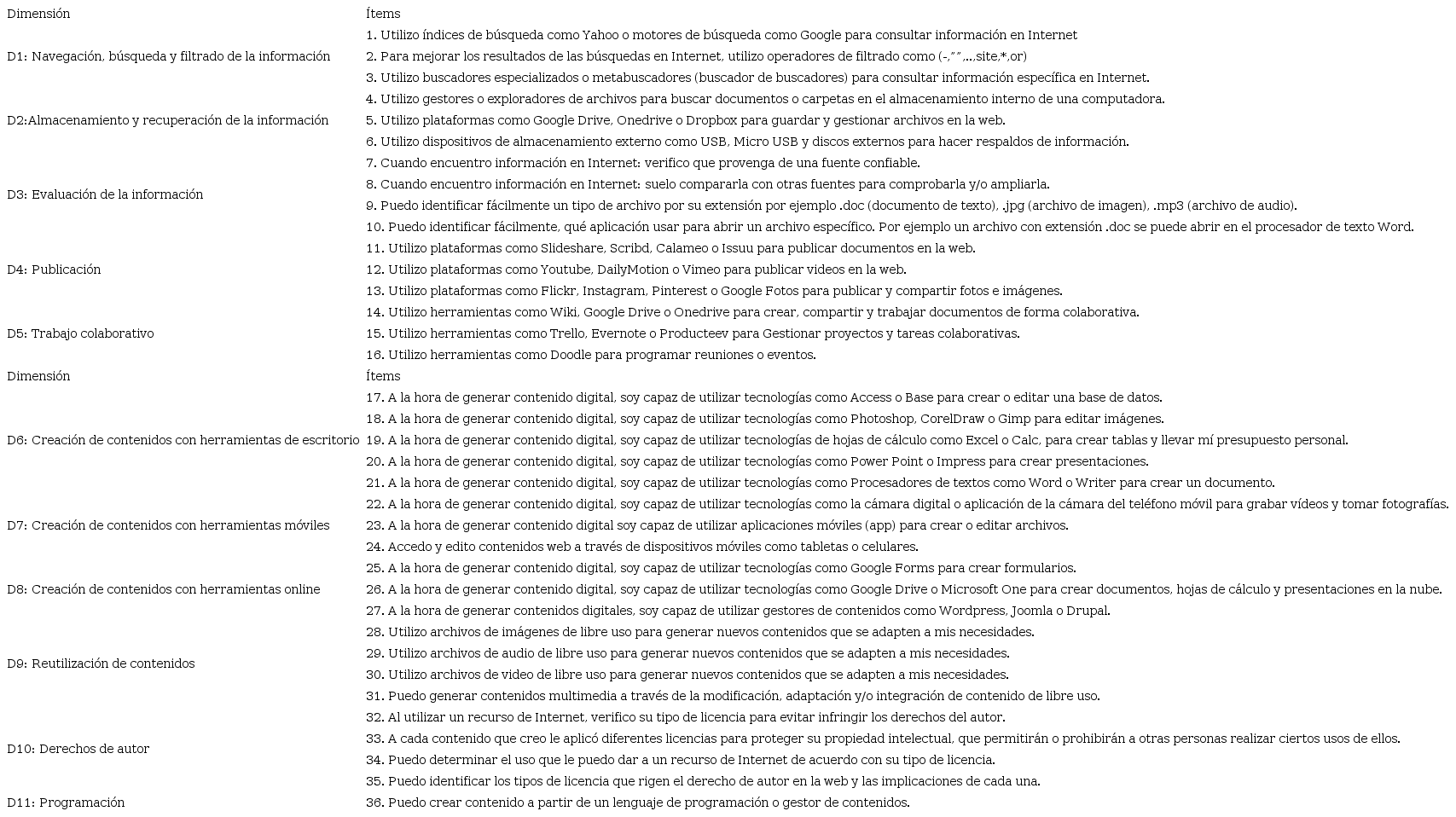

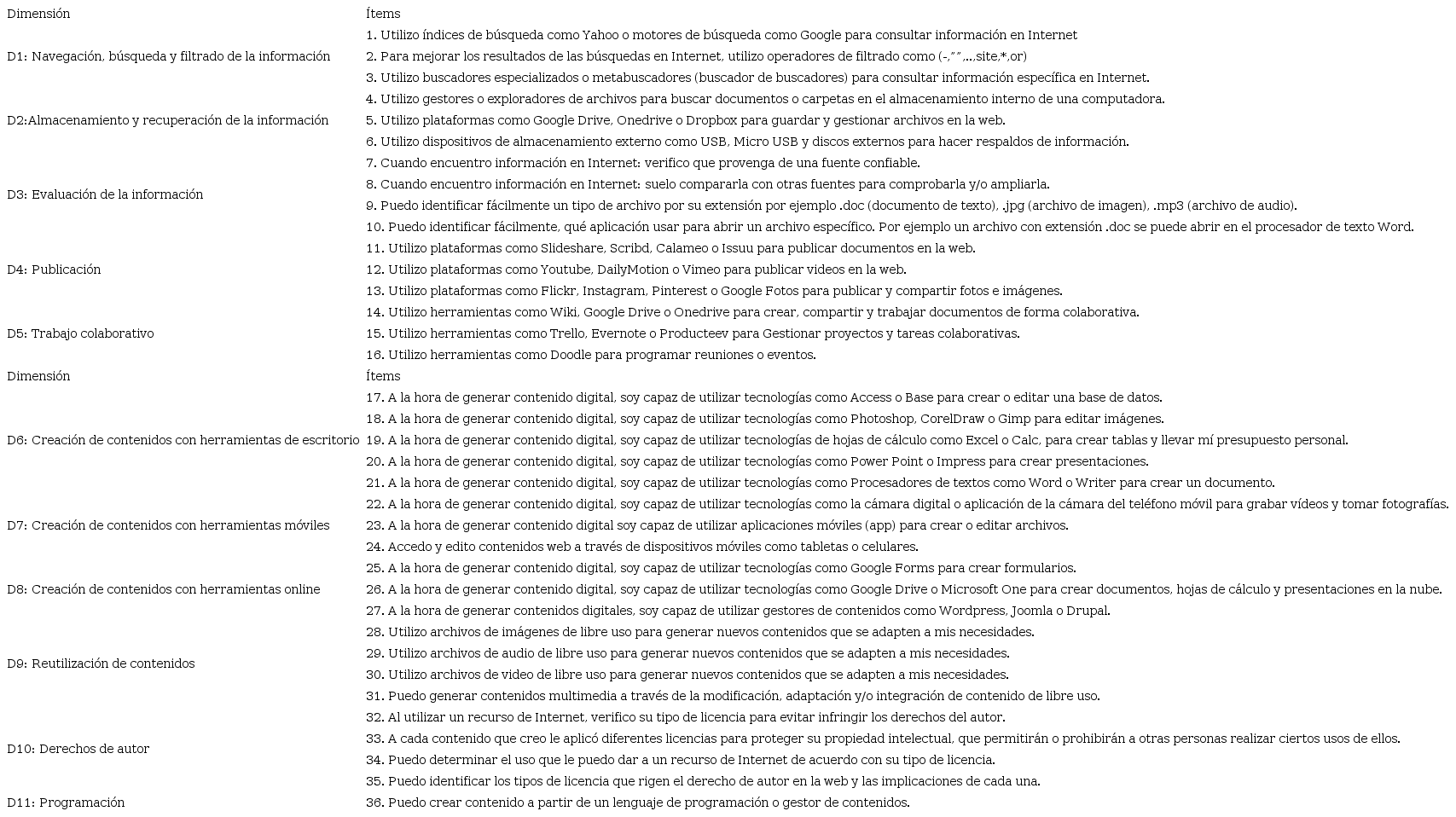

Inicialmente se construyó un primer instrumento con 100 reactivos, abarcando las 21 competencias de las cinco dimensiones mostradas en la Tabla 1. Para esta primera escala, se tomó como referencia la herramienta de autodiagnóstico en competencias digitales diseñada por la junta de Andalucía España y que hace parte del ecosistema de portales: Andalucía es Digital (Junta de Andalucía, 2010). La herramienta de referencia está diseñada bajo los lineamientos de competencias digitales del Marco Común Europeo, pero enfocado al contexto español. Sin embargo, luego de priorizar las competencias más pertinentes para la salida ocupacional del programa de media técnica al que pertenece la población objeto de estudio, se ajustó el instrumento a 36 ítems o reactivos agrupados en 11 dimensiones, como se muestra en la Tabla 2 del presente artículo.

Tabla 2.

Agrupación de los ítems de acuerdo con los lineamientos del modelo teórico

Fuente: elaboración propia.

Fuente: elaboración propia.

|

Dimensión

|

Ítems

|

|

D1: Navegación, búsqueda y filtrado de la información

|

1. Utilizo índices de búsqueda como Yahoo o motores de búsqueda como Google para consultar información en Internet

|

|

2. Para mejorar los resultados de las búsquedas en Internet, utilizo operadores de filtrado como (-,””,..,site,*,or)

|

|

3. Utilizo buscadores especializados o metabuscadores (buscador de buscadores) para consultar información específica en Internet.

|

|

D2:Almacenamiento y recuperación de la información

|

4. Utilizo gestores o exploradores de archivos para buscar documentos o carpetas en el almacenamiento interno de una computadora.

|

|

5. Utilizo plataformas como Google Drive, Onedrive o Dropbox para guardar y gestionar archivos en la web.

|

|

6. Utilizo dispositivos de almacenamiento externo como USB, Micro USB y discos externos para hacer respaldos de información.

|

|

D3: Evaluación de la información

|

7. Cuando encuentro información en Internet: verifico que provenga de una fuente confiable.

|

|

8. Cuando encuentro información en Internet: suelo compararla con otras fuentes para comprobarla y/o ampliarla.

|

|

9. Puedo identificar fácilmente un tipo de archivo por su extensión por ejemplo .doc (documento de texto), .jpg (archivo de imagen), .mp3 (archivo de audio).

|

|

10. Puedo identificar fácilmente, qué aplicación usar para abrir un archivo específico. Por ejemplo un archivo con extensión .doc se puede abrir en el procesador de texto Word.

|

|

D4: Publicación

|

11. Utilizo plataformas como Slideshare, Scribd, Calameo o Issuu para publicar documentos en la web.

|

|

12. Utilizo plataformas como Youtube, DailyMotion o Vimeo para publicar videos en la web.

|

|

13. Utilizo plataformas como Flickr, Instagram, Pinterest o Google Fotos para publicar y compartir fotos e imágenes.

|

|

D5: Trabajo colaborativo

|

14. Utilizo herramientas como Wiki, Google Drive o Onedrive para crear, compartir y trabajar documentos de forma colaborativa.

|

|

15. Utilizo herramientas como Trello, Evernote o Producteev para Gestionar proyectos y tareas colaborativas.

|

|

16. Utilizo herramientas como Doodle para programar reuniones o eventos.

|

|

Dimensión

|

Ítems

|

|

D6: Creación de contenidos con herramientas de escritorio

|

17. A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Access o Base para crear o editar una base de datos.

|

|

18. A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Photoshop, CorelDraw o Gimp para editar imágenes.

|

|

19. A la hora de generar contenido digital, soy capaz de utilizar tecnologías de hojas de cálculo como Excel o Calc, para crear tablas y llevar mí presupuesto personal.

|

|

20. A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Power Point o Impress para crear presentaciones.

|

|

21. A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Procesadores de textos como Word o Writer para crear un documento.

|

|

D7: Creación de contenidos con herramientas móviles

|

22. A la hora de generar contenido digital, soy capaz de utilizar tecnologías como la cámara digital o aplicación de la cámara del teléfono móvil para grabar vídeos y tomar fotografías.

|

|

23. A la hora de generar contenido digital soy capaz de utilizar aplicaciones móviles (app) para crear o editar archivos.

|

|

24. Accedo y edito contenidos web a través de dispositivos móviles como tabletas o celulares.

|

|

D8: Creación de contenidos con herramientas online

|

25. A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Google Forms para crear formularios.

|

|

26. A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Google Drive o Microsoft One para crear documentos, hojas de cálculo y presentaciones en la nube.

|

|

27. A la hora de generar contenidos digitales, soy capaz de utilizar gestores de contenidos como Wordpress, Joomla o Drupal.

|

|

D9: Reutilización de contenidos

|

28. Utilizo archivos de imágenes de libre uso para generar nuevos contenidos que se adapten a mis necesidades.

|

|

29. Utilizo archivos de audio de libre uso para generar nuevos contenidos que se adapten a mis necesidades.

|

|

30. Utilizo archivos de video de libre uso para generar nuevos contenidos que se adapten a mis necesidades.

|

|

31. Puedo generar contenidos multimedia a través de la modificación, adaptación y/o integración de contenido de libre uso.

|

|

D10: Derechos de autor

|

32. Al utilizar un recurso de Internet, verifico su tipo de licencia para evitar infringir los derechos del autor.

|

|

33. A cada contenido que creo le aplicó diferentes licencias para proteger su propiedad intelectual, que permitirán o prohibirán a otras personas realizar ciertos usos de ellos.

|

|

34. Puedo determinar el uso que le puedo dar a un recurso de Internet de acuerdo con su tipo de licencia.

|

|

35. Puedo identificar los tipos de licencia que rigen el derecho de autor en la web y las implicaciones de cada una.

|

|

D11: Programación

|

36. Puedo crear contenido a partir de un lenguaje de programación o gestor de contenidos.

|

METODOLOGÍA

Tipo de estudio

El presente proyecto de investigación es cuantitativo descriptivo. El estudio pretende realizar un análisis del constructo de competencias digitales y cada una de sus dimensiones a través del diseño, validación y aplicación de una escala de valoración. La selección de este enfoque de investigación se sustenta en Sampieri, Collado, & Lucio (2014) los cuales expresan: «… los estudios descriptivos son útiles para mostrar con precisión los ángulos o dimensiones de un fenómeno, suceso, comunidad, contexto o situación» (p. 92).

Participantes

La muestra para la validación se conformó por 515 estudiantes de instituciones de educación pública de Medellín que tienen entre sus modalidades de formación la media técnica, concebida como la articulación de la educación media académica con formación profesional en el nivel técnico de una disciplina específica. Entonces, solo participaron estudiantes matriculados en grado noveno, décimo y undécimo. La muestra fue obtenida a partir del muestreo aleatorio simple. De la muestra 278 estudiantes son mujeres (54 %) y 237 son hombres (46 %). La media de edad en la muestra de estudiantes es de 16 años, con una desviación estándar de 0,967. Para la aplicación, la Escala de Valoración de Competencias Digitales (EVCD, por sus siglas en español) se sistematizó a través de una herramienta digital online y se aplicó a los estudiantes, previo consentimiento informado por parte de los rectores de las instituciones y los padres de familia de los estudiantes. Durante el proceso de aplicación de la escala, se socializaron los objetivos del estudio, su importancia y el concepto de competencias digitales, así mismo, se realizó un acompañamiento con cada grupo para garantizar la objetividad de los estudiantes al momento de responder la encuesta y aclarar dudas que se presentaran en la ejecución de la misma. Lo anterior para disminuir el porcentaje de error humano asociado a posibles sesgos dados por malas interpretaciones de los ítems.

Cuestionario

La Escala de Valoración de Competencias Digitales EVCD se construyó a partir de los lineamientos de competencias digitales dados por el Marco Común Europeo como resultado del proyecto DIGCOMP y se estructuró a través de 36 ítems, utilizando una escala Likert con los siguientes niveles de respuesta: 1: Nunca, 2: Casi Nunca, 3: Algunas Veces, 4: Casi Siempre, 5: Siempre. Una vez estructurado el instrumento se digitalizó a través de una herramienta online para su aplicación.

Procedimiento validación del instrumento

La validación del instrumento se llevó a cabo en tres fases:

Fase I: Validación de contenido

La verificación de la validez de contenido es una tarea importante dentro del proceso de validación de un instrumento de medición, ya que tiene como objetivo verificar la pertinencia de los ítems o reactivos del mismo con las dimensiones teóricas u objetos de estudio definidas por el investigador y con las características idiomáticas y culturales de la población a la cuál va dirigido. En la mayoría de los casos, la validación de contenidos se lleva a cabo a través de la técnica de juicio de expertos (Pérez & Martínez, 2008).

Juicio de expertos

Para realizar el juicio de expertos se tuvo en cuenta los siguientes pasos propuestos por Pérez & Martínez (2008, p. 4):

- 1.

Definición del objetivo: determinar, mediante la Técnica de Juicio de Expertos, la evaluación de contenido que hacen los jueces del instrumento: escala de valoración de competencias digitales, teniendo en cuenta los criterios de suficiencia, claridad, coherencia y relevancia de los reactivos de la escala con el fundamento teórico y las características y el contexto de la población objeto de estudio.

- 2.

Selección de los jueces: para la selección de los expertos se tuvo en cuenta los criterios de formación académica y experiencia profesional. Se seleccionaron 7 jueces entre los cuales 5 tenían formación y experiencia en el campo de las tecnologías de la información y las comunicaciones y dos en el área de lingüística. Previo verificación de su deseo de participar de la evaluación del instrumento, a los jueces se les envió: formatos de consentimiento informado y confidencialidad, fundamentos teóricos del Marco Común Europeo de competencias digitales, características demográficas del contexto en el que sería aplicado el instrumento, criterios de evaluación, la escala de valoración y la plantilla de evaluación.

- 3.

Establecer criterios y pesos diferenciales de las dimensiones de la prueba: Los criterios definidos para la evaluación de cada ítem o reactivo fueron:

-

Suficiencia: los ítems que pertenecen a una misma dimensión bastan para obtener la medición de esta. Nota: a todos los ítems pertenecientes a una misma dimensión se les asigna una sola calificación.

-

Claridad: el enunciado del ítem no genera confusión o contradicciones.

-

Coherencia: el ítem tiene relación lógica con la dimensión o indicador que está midiendo.

-

Relevancia: el ítem es importante, es decir, debe ser incluido en el instrumento.

La escala de medición para cada criterio estaba dada por:

1: No cumple 2: Nivel bajo 3: Nivel moderado 4. Nivel alto

4. Calcular la concordancia entre jueces: para este cálculo se consideraron dos estadísticos: Índice de Validez de Contenido (Lawshe, 1975) y el Coeficiente de Validez de Contenido (Nieto, 2002). La información de cada uno de los estadísticos y su interpretación se muestra en la Tabla 3:

Fase II: Validación de constructo

El objetivo de esta fase fue la recolección de datos para cada uno de los ítems del instrumento y su posterior agrupación probabilística, a través de la aplicación de una técnica de estadística multivariada. Para lo cual, se digitalizó el instrumento a través de una herramienta online para facilitar su aplicación, se realizó la socialización del estudio con las instituciones educativas y se capacitó a los docentes que estarían encargados de su aplicación. Los resultados se recolectaban automáticamente en una base de datos que posteriormente fue importada al software SPSS (IBM, 2017) para realizar los cálculos estadísticos.

Tabla 3.

Estadísticos validación de contenido.

Fuente: elaboración propia en consonancia con los lineamientos dados en Pedrosa et al., (2014).

Fuente: elaboración propia en consonancia con los lineamientos dados en Pedrosa et al., (2014).

|

Estadístico

|

Fórmula

|

Criterios

|

Interpretación

|

|

Índice de Validez de Contenido

(Lawshe, 1975)

|

Razón de validez de contenido:

RVC= (n - N/2)/(N/2),

n=Número de expertos que otorgan la calificación esencial al ítem.

N=Número total de expertos.

Índice de validez de contenido:

IVC= Promedio de los RVC de todos los ítems.

|

Criterios para evaluar cada ítem por parte de experto:

Puntaje >=3: El elemento es esencial

Puntaje = 2: El elemento es útil pero prescindible

Puntaje = 1: El elemento es innecesario

|

Si bien para Davis (1992) citado en (Pedrosa, Álvarez, & Cueto, 2014, p. 8), para un IVC>=0.80 se puede interpretar como un conjunto de ítem adecuados.

Lawshe (1975) expresa que la interpretación del IVC debe hacerse a la luz del número de expertos utilizados. Así, para 7 expertos o menos, el IVC debe ser igual a 0.99; y para un número de expertos entre 9 y 40, el valor del IVC debe estar entre 0.29 y 0.78, respectivamente.

|

|

Coeficiente de Validez de Contenido

(Nieto, 2002)

|

Coeficiente de validez de contenido:

CVC = CVCi – Pei Donde,

CVCi = Mx/Vmáx

Mx = media de la puntuación dada por los expertos para cada ítem.

Vmáx = puntuación máxima promedio que el ítem podría alcanzar.

Error asignado a cada ítem (para reducción de posibles sesgos introducido por alguno de los jueces)

Pei = (1/j )^j siendo j el número de expertos participantes.

|

Criterios para evaluar cada ítem por parte de experto:

Puntaje >=3: El elemento es esencial.

Puntaje = 2: El elemento es útil pero prescindible.

Puntaje = 1: El elemento es innecesario.

|

Nieto (2002) recomienda mantener únicamente aquellos ítems con un CVC superior a 0.80, aunque algunos criterios menos estrictos establecen valores superiores a 0.70 Balbinotti (2004), citado en (Pedrosa et al., 2014)

|

En un primer momento, los datos recolectados a través de la aplicación del instrumento se sometieron a un Análisis Factorial Exploratorio (AFE) con el objetivo de conocer de forma estadística como se agrupan los ítems del instrumento y formar dimensiones a través de la aplicación del procedimiento estadístico de reducción de factores. Para el análisis factorial exploratorio fue necesario, en primera instancia, verificar si existía una fuerte correlación entre los ítems del instrumento que permitiera la creación de dimensiones. Para verificar lo anterior se consideraron las siguientes pruebas estadísticas:

Prueba de esfericidad de Bartlett: esta prueba mide la correlación entre los factores, con H0 (hipótesis nula): los ítem de la escala son independientes entre sí. Y Ha (hipótesis alterna): los ítem de la escala son dependientes (con alta correlación entre ellos que les permite agruparse en uno o más factores de un constructo). Para rechazar la hipótesis nula se necesita un valor de probabilidad menor a 5 % (Hair, Anderson, Tatham, & Black, 1999).

Medida Kaiser-Meyer-Olkin de adecuación de muestreo (KMO): la cual evalúa la fuerza de relación entre ítems a partir de las correlaciones parciales, puede tomar valores entre 0 y 1. En el análisis factorial exploratorio son aceptados los valores superiores a 0,7 (Hair et al., 1999).

En segunda instancia se realiza la extracción de factores. Para este caso se utilizó el método de máxima verosimilitud, ya que se buscaba reducir el número de factores agrupando los ítems de acuerdo con los que presentaran mayor similitud en sus varianzas y teniendo en cuenta que el número de factores no estaba establecido previamente, tomando como criterio factores con auto valores iniciales mayores o iguales a 1(Aráuz, 2015).

Para facilitar la lectura de los resultados en un primer momento, se realiza el cálculo de la matriz de factores y posteriormente la matriz de factores rotados, a través de una rotación ortogonal con el método de rotación Varimax, que maximiza la ponderación de los factores, considerando los ítems mayores a |0,4| para mantener en el instrumento final. Otros autores recomiendan mantener los factores que agrupen 3 o más ítems o aquellos cuya carga factorial sea igual o superior 0.3 (Méndez & Rondón, 2012).

Análisis confirmatorio con ecuaciones estructurales

Para realizar el análisis confirmatorio se utilizó el análisis de ecuaciones estructurales (SEM), la cual es una técnica de gran utilidad para evaluar modelos que establecen relaciones entre variables, permitiendo verificar si las relaciones observables entre dichas variables se ajustan a los datos empíricos. Para simplificar los cálculos se utilizó el software R (Ihaka & Gentleman, 2018), específicamente el paquete Lavaan, el cual permite una escritura sencilla de los modelos y realiza análisis relativamente complejos. Dentro del paquete Lavaan se utilizó la función cfa() la cual está orientada al cálculo de análisis factorial confirmatorio, arrojando los índices o medidas de bondad de ajuste, tanto global como incremental, que permiten verificar si el modelo es compatible con los datos empíricos (Sallan, Fernández, Simo, Lordan, & González, 2012).

Teniendo en cuenta los resultados arrojados por el software una vez se corrió el modelo, los dos primeros índices de bondad de ajuste analizados fueron la raíz de error cuadrático medio de la aproximación (RMSEA, por sus siglas en inglés) y el Residuo Cuadrático Medio (RMSR), los cuales evalúan qué tan bien se ajusta el modelo a la población. Para el primero, se considera un buen ajuste valores Inferiores a .08 (preferiblemente, inferior a .06); y para el segundo, valores inferiores a .08 (mejor mientras más próximo a .00). El otro grupo de índices analizados fue Tucker-Lewis Index (TLI) y Comparative Fit Index (CFI) basados en la comparación del modelo con un modelo nulo. Para estos índices, valores cercanos a 1 (>.90) garantizan que el modelo ajustado es mejor que un modelo nulo (Arias, 2008, p. 10).

Fase III: Análisis de fiabilidad

Criterios establecidos por la psicometría exponen que toda escala de medición debe cumplir con las propiedades de validez o grado en que un instrumento mide lo que pretende medir y la propiedad de fiabilidad en la que el instrumento debe proporcionar resultados similares para diferentes poblaciones o grupos de aplicación (Frías, 2014, p. 1). Con base en lo anterior, en esta fase se procedió a realizar el análisis de fiabilidad del instrumento a través del método de cálculo de coeficiente de consistencia interna. Para ello se realizó el cálculo de Alfa de Cronbach, para el cual se obtienen resultados que pueden oscilar entre 0 y 1. Siendo los valores más cercanos a 1 los que determinan una mayor consistencia interna de los ítems evaluados.

George & Mallery (2003) establecen los siguientes criterios, a tener en cuenta en el momento de analizar los resultados de alfa de Cronbach: Coeficiente alfa >.9 es excelente, Coeficiente alfa >.8 es bueno, Coeficiente alfa >.7 es aceptable, Coeficiente alfa >.6 es cuestionable, Coeficiente alfa >.5 es pobre y finalmente, Coeficiente alfa <.5 es inaceptable (p. 231).

ANÁLISIS DE RESULTADOS

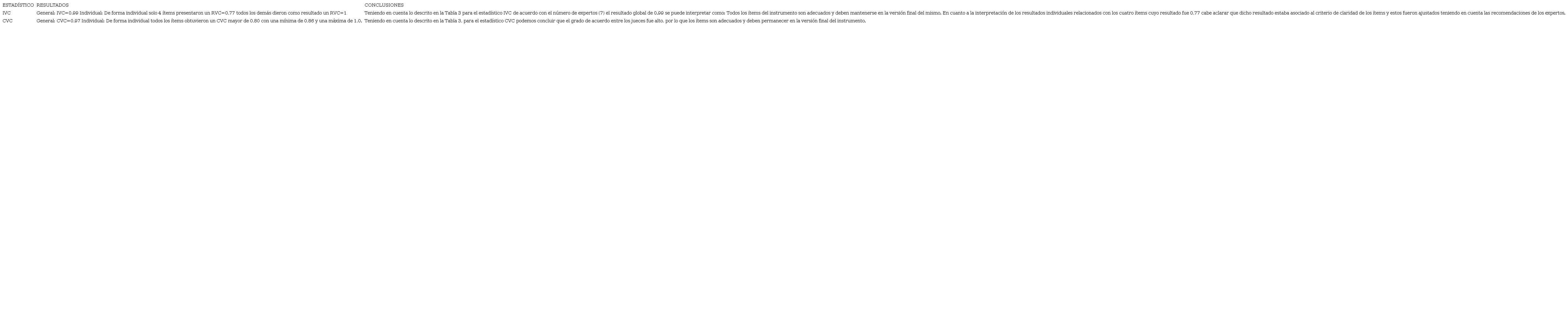

Validez de Contenido

Los resultados obtenidos a través del cálculo de los estadísticos utilizados, así como las conclusiones de la validez de contenidos, se describen en la Tabla 4.

Tabla 4.

Análisis de los resultados de validación de contenidos

Fuente: elaboración propia.

Fuente: elaboración propia.

|

ESTADÍSTICO

|

RESULTADOS

|

CONCLUSIONES

|

|

IVC

|

General:

IVC=0,99

Individual: De forma individual solo 4 ítems presentaron un RVC=0,77 todos los demás dieron como resultado un RVC=1

|

Teniendo en cuenta lo descrito en la Tabla 3 para el estadístico IVC de acuerdo con el número de expertos (7) el resultado global de 0.99 se puede interpretar como: Todos los ítems del instrumento son adecuados y deben mantenerse en la versión final del mismo.

En cuanto a la interpretación de los resultados individuales relacionados con los cuatro ítems cuyo resultado fue 0,77 cabe aclarar que dicho resultado estaba asociado al criterio de claridad de los ítems y estos fueron ajustados teniendo en cuenta las recomendaciones de los expertos.

|

|

CVC

|

General:

CVC=0,97

Individual: De forma individual todos los ítems obtuvieron un CVC mayor de 0,80 con una mínima de 0,86 y una máxima de 1,0.

|

Teniendo en cuenta lo descrito en la Tabla 3, para el estadístico CVC podemos concluir que el grado de acuerdo entre los jueces fue alto, por lo que los ítems son adecuados y deben permanecer en la versión final del instrumento.

|

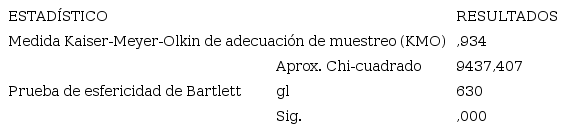

Validez de Constructo Factorial

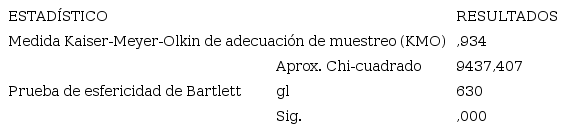

De acuerdo con los resultados presentados en la Tabla 5, el KMO muy cercano a 1 y el p-valor (sig.) arrojado en la prueba de esfericidad de Bartlett está por debajo del 5 %, esto permite rechazar la hipótesis nula y aceptar la hipótesis alterna: Ha (hipótesis alterna): los ítems de la escala son dependientes (con alta correlación entre ellos que les permite agruparse en uno o más factores de un constructo). Por lo que se puede concluir que existen fuerte correlación entre los ítem del instrumento (Hair et al., 1999).

Tabla 5.

Prueba de KMO y Bartlett

Fuente: resultado Software SPSS.

Fuente: resultado Software SPSS.

|

ESTADÍSTICO

|

RESULTADOS

|

|

Medida Kaiser-Meyer-Olkin de adecuación de muestreo (KMO)

|

,934

|

|

Prueba de esfericidad de Bartlett

|

Aprox. Chi-cuadrado

|

9437,407

|

|

gl

|

630

|

|

Sig.

|

,000

|

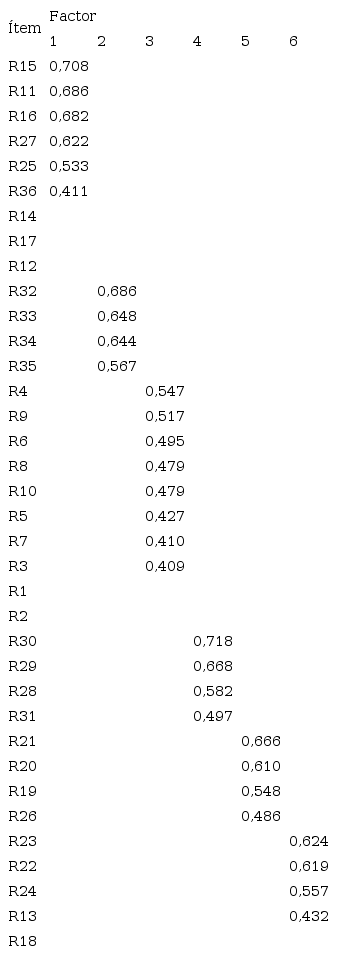

Análisis Factorial Exploratorio (AFE)

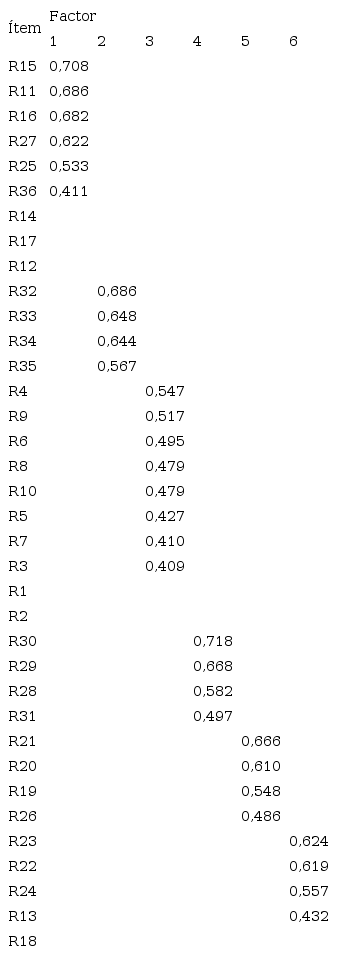

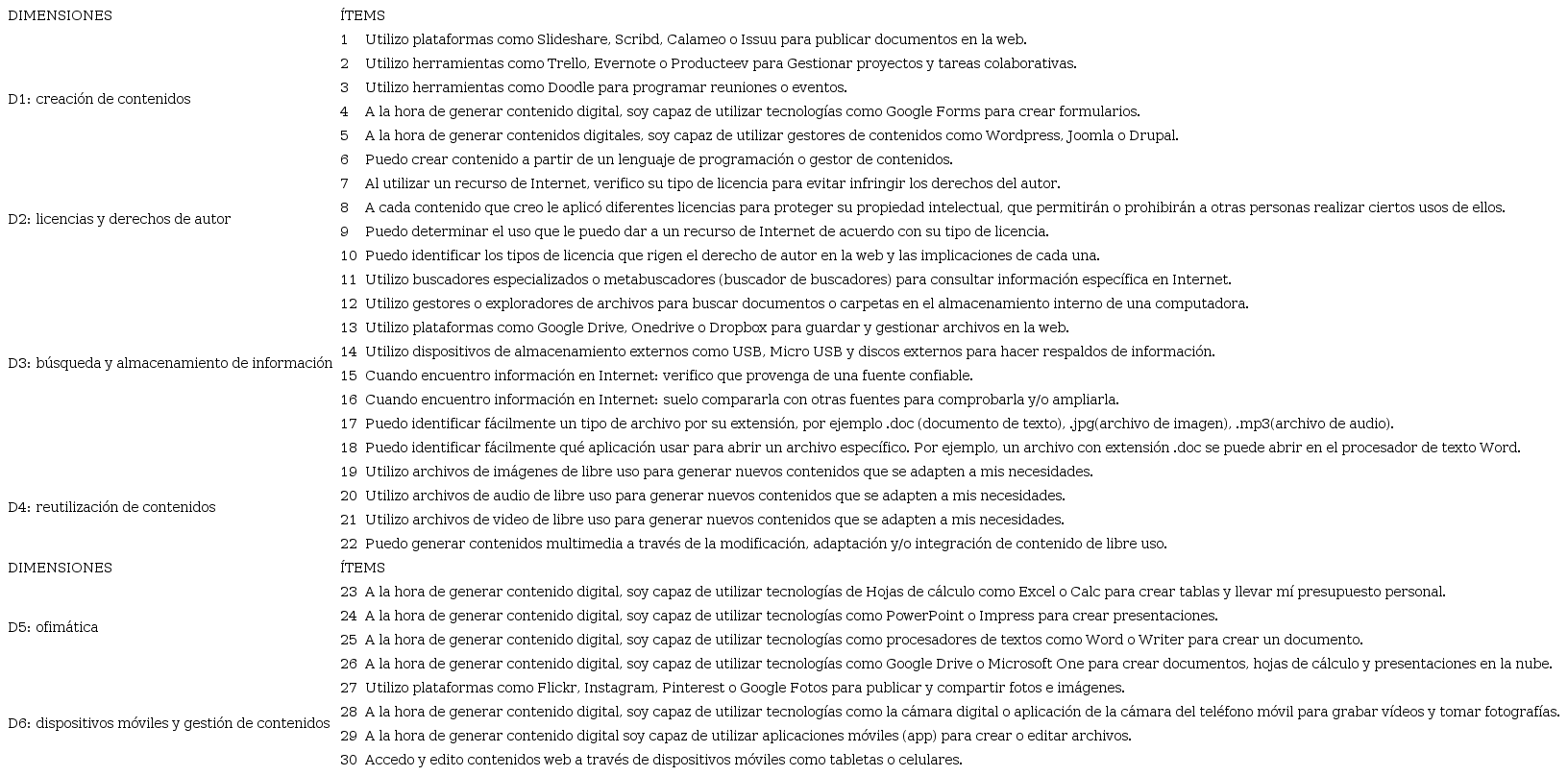

La extracción de factores mostró 6 factores con auto valores iniciales mayores o iguales a 1 (Aráuz, 2015), los cuales explicaban el 54,026 % de la varianza total y todos estos factores agrupaban más de 3 ítems, cuyas cargas factoriales estaban por encima de 0.4 (Méndez & Rondón, 2012). La Tabla 6 muestra la agrupación de ítem alrededor de sus respectivas nuevas dimensiones o factores:

Como podemos observar, en la Tabla 6, 6 de los ítems (R14, R17, R12, R1, R2, R18) no tiene cargas factoriales asignadas, por lo tanto, no cumplen con el criterio de tener cargas factoriales superiores a 0,3. Por esta razón, no se incluyeron en el instrumento final. Así después de análisis factorial exploratorio se pasó de un modelo teórico inicial que tenía 11 dimensiones o factores y 36 ítems, a uno con 6 dimensiones y 30 ítems. La Tabla 7 muestra las nuevas dimensiones con sus respectivos reactivos.

Tabla 6.

Matriz de factor rotado

Fuente: resultado Software SPSS.

Fuente: resultado Software SPSS.

|

Ítem

|

Factor

|

|

1

|

2

|

3

|

4

|

5

|

6

|

|

R15

|

0,708

| | | | | |

|

R11

|

0,686

| | | | | |

|

R16

|

0,682

| | | | | |

|

R27

|

0,622

| | | | | |

|

R25

|

0,533

| | | | | |

|

R36

|

0,411

| | | | | |

|

R14

| | | | | | |

|

R17

| | | | | | |

|

R12

| | | | | | |

|

R32

| |

0,686

| | | | |

|

R33

| |

0,648

| | | | |

|

R34

| |

0,644

| | | | |

|

R35

| |

0,567

| | | | |

|

R4

| | |

0,547

| | | |

|

R9

| | |

0,517

| | | |

|

R6

| | |

0,495

| | | |

|

R8

| | |

0,479

| | | |

|

R10

| | |

0,479

| | | |

|

R5

| | |

0,427

| | | |

|

R7

| | |

0,410

| | | |

|

R3

| | |

0,409

| | | |

|

R1

| | | | | | |

|

R2

| | | | | | |

|

R30

| | | |

0,718

| | |

|

R29

| | | |

0,668

| | |

|

R28

| | | |

0,582

| | |

|

R31

| | | |

0,497

| | |

|

R21

| | | | |

0,666

| |

|

R20

| | | | |

0,610

| |

|

R19

| | | | |

0,548

| |

|

R26

| | | | |

0,486

| |

|

R23

| | | | | |

0,624

|

|

R22

| | | | | |

0,619

|

|

R24

| | | | | |

0,557

|

|

R13

| | | | | |

0,432

|

|

R18

| | | | | | |

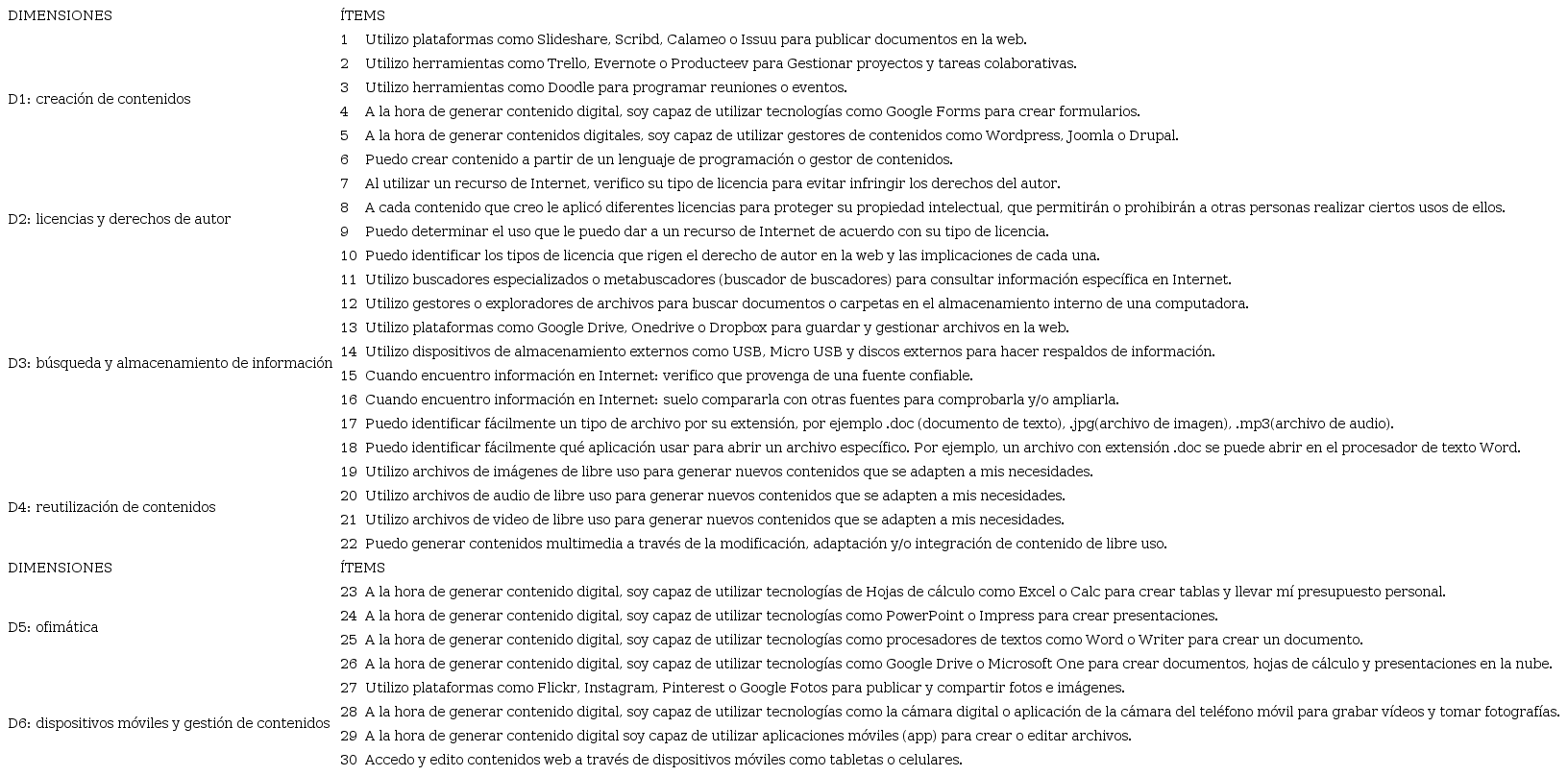

Tabla 7.

Agrupación de dimensiones e ítem después del análisis factorial exploratorio

Fuente: elaboración propia.

Fuente: elaboración propia.

|

DIMENSIONES

|

ÍTEMS

|

|

D1: creación de contenidos

|

1

|

Utilizo plataformas como Slideshare, Scribd, Calameo o Issuu para publicar documentos en la web.

|

|

2

|

Utilizo herramientas como Trello, Evernote o Producteev para Gestionar proyectos y tareas colaborativas.

|

|

3

|

Utilizo herramientas como Doodle para programar reuniones o eventos.

|

|

4

|

A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Google Forms para crear formularios.

|

|

5

|

A la hora de generar contenidos digitales, soy capaz de utilizar gestores de contenidos como Wordpress, Joomla o Drupal.

|

|

6

|

Puedo crear contenido a partir de un lenguaje de programación o gestor de contenidos.

|

|

D2: licencias y derechos de autor

|

7

|

Al utilizar un recurso de Internet, verifico su tipo de licencia para evitar infringir los derechos del autor.

|

|

8

|

A cada contenido que creo le aplicó diferentes licencias para proteger su propiedad intelectual, que permitirán o prohibirán a otras personas realizar ciertos usos de ellos.

|

|

9

|

Puedo determinar el uso que le puedo dar a un recurso de Internet de acuerdo con su tipo de licencia.

|

|

10

|

Puedo identificar los tipos de licencia que rigen el derecho de autor en la web y las implicaciones de cada una.

|

|

D3: búsqueda y almacenamiento de información

|

11

|

Utilizo buscadores especializados o metabuscadores (buscador de buscadores) para consultar información específica en Internet.

|

|

12

|

Utilizo gestores o exploradores de archivos para buscar documentos o carpetas en el almacenamiento interno de una computadora.

|

|

13

|

Utilizo plataformas como Google Drive, Onedrive o Dropbox para guardar y gestionar archivos en la web.

|

|

14

|

Utilizo dispositivos de almacenamiento externos como USB, Micro USB y discos externos para hacer respaldos de información.

|

|

15

|

Cuando encuentro información en Internet: verifico que provenga de una fuente confiable.

|

|

16

|

Cuando encuentro información en Internet: suelo compararla con otras fuentes para comprobarla y/o ampliarla.

|

|

17

|

Puedo identificar fácilmente un tipo de archivo por su extensión, por ejemplo .doc (documento de texto), .jpg(archivo de imagen), .mp3(archivo de audio).

|

|

18

|

Puedo identificar fácilmente qué aplicación usar para abrir un archivo específico. Por ejemplo, un archivo con extensión .doc se puede abrir en el procesador de texto Word.

|

|

D4: reutilización de contenidos

|

19

|

Utilizo archivos de imágenes de libre uso para generar nuevos contenidos que se adapten a mis necesidades.

|

|

20

|

Utilizo archivos de audio de libre uso para generar nuevos contenidos que se adapten a mis necesidades.

|

|

21

|

Utilizo archivos de video de libre uso para generar nuevos contenidos que se adapten a mis necesidades.

|

|

22

|

Puedo generar contenidos multimedia a través de la modificación, adaptación y/o integración de contenido de libre uso.

|

|

DIMENSIONES

|

ÍTEMS

|

|

D5: ofimática

|

23

|

A la hora de generar contenido digital, soy capaz de utilizar tecnologías de Hojas de cálculo como Excel o Calc para crear tablas y llevar mí presupuesto personal.

|

|

24

|

A la hora de generar contenido digital, soy capaz de utilizar tecnologías como PowerPoint o Impress para crear presentaciones.

|

|

25

|

A la hora de generar contenido digital, soy capaz de utilizar tecnologías como procesadores de textos como Word o Writer para crear un documento.

|

|

26

|

A la hora de generar contenido digital, soy capaz de utilizar tecnologías como Google Drive o Microsoft One para crear documentos, hojas de cálculo y presentaciones en la nube.

|

|

D6: dispositivos móviles y gestión de contenidos

|

27

|

Utilizo plataformas como Flickr, Instagram, Pinterest o Google Fotos para publicar y compartir fotos e imágenes.

|

|

28

|

A la hora de generar contenido digital, soy capaz de utilizar tecnologías como la cámara digital o aplicación de la cámara del teléfono móvil para grabar vídeos y tomar fotografías.

|

|

29

|

A la hora de generar contenido digital soy capaz de utilizar aplicaciones móviles (app) para crear o editar archivos.

|

|

30

|

Accedo y edito contenidos web a través de dispositivos móviles como tabletas o celulares.

|

Análisis Factorial Confirmatorio (AFC)

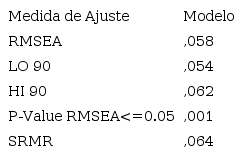

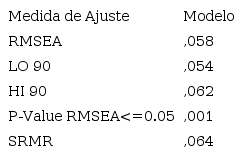

Los cálculos de ecuaciones estructurales realizados en el paquete Lavaan del software R arrojan como resultados los presentados en las Tablas 8 y 9. En la Tabla 8 podemos observar que los valores obtenidos están dentro de los rangos o criterios de análisis, para concluir que los datos se ajustan al modelo propuesto.

Tabla 8.

Medidas de ajuste global del modelo

Fuente: elaboración propia a partir de los resultados arrojados por el software R.

Fuente: elaboración propia a partir de los resultados arrojados por el software R.

|

Medida de Ajuste

|

Modelo

|

|

RMSEA

|

,058

|

|

LO 90

|

,054

|

|

HI 90

|

,062

|

|

P-Value RMSEA<=0.05

|

,001

|

|

SRMR

|

,064

|

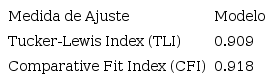

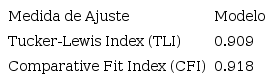

Por otro lado, la Tabla 9 muestra dos de los índices incrementales de ajuste con valores superiores a .90, resultado a partir del cual se puede concluir que el modelo ajustado es mejor que un modelo nulo.

Tabla 9.

Índices incrementales de ajuste

Fuente: elaboración propia a partir de los resultados arrojados por el software R.

Fuente: elaboración propia a partir de los resultados arrojados por el software R.

|

Medida de Ajuste

|

Modelo

|

|

Tucker-Lewis Index (TLI)

|

0.909

|

|

Comparative Fit Index (CFI)

|

0.918

|

En general, después de analizar los datos arrojados por el análisis factorial confirmatorio, se puede concluir que el modelo se ajusta a los datos empíricos recogidos durante la aplicación del instrumento.

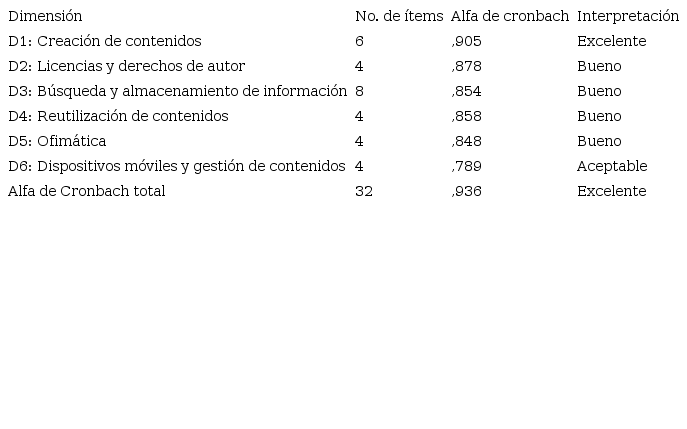

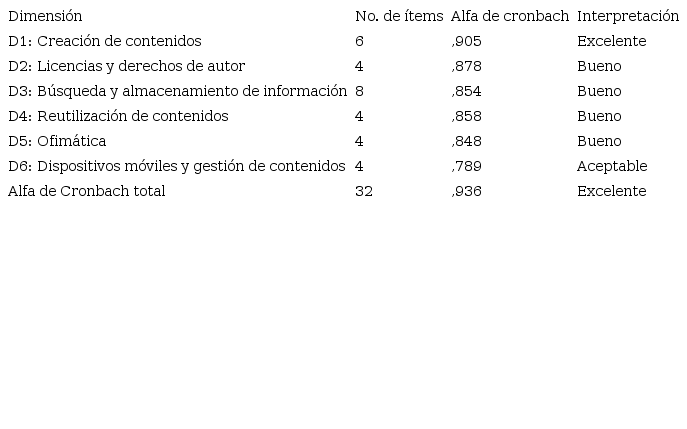

Fiabilidad

Los resultados de los cálculos de fiabilidad realizados en el software SPSS a través de la prueba de Alfa de Cronbach se presentan en la Tabla 10, de la cual se puede concluir que, tanto de forma individual como global, los ítems evaluados presentan un alto grado de consistencia interna cumpliendo con los criterios de fiabilidad.

Tabla 10.

Resultados análisis de fiabilidad

Fuente: elaboración propia a partir de los resultados arrojados por el software SPSS.

Fuente: elaboración propia a partir de los resultados arrojados por el software SPSS.

|

Dimensión

|

No. de ítems

|

Alfa de cronbach

|

Interpretación

|

|

D1: Creación de contenidos

|

6

|

,905

|

Excelente

|

|

D2: Licencias y derechos de autor

|

4

|

,878

|

Bueno

|

|

D3: Búsqueda y almacenamiento de información

|

8

|

,854

|

Bueno

|

|

D4: Reutilización de contenidos

|

4

|

,858

|

Bueno

|

|

D5: Ofimática

|

4

|

,848

|

Bueno

|

|

D6: Dispositivos móviles y gestión de contenidos

|

4

|

,789

|

Aceptable

|

|

Alfa de Cronbach total

|

32

|

,936

|

Excelente

|

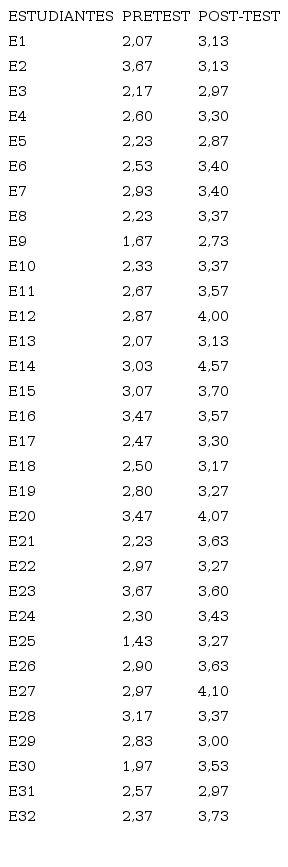

Aplicación del instrumento

El instrumento Escala de Valoración de Competencias Digitales (EVCD), una vez validado, se aplicó a una muestra de 32 estudiantes de media técnica del programa diseño e integración de multimedia de la I.E. Finca la Mesa, del municipio de Medellín. Los estudiantes seleccionados pertenecen al grado décimo e iniciaron su proceso formativo de media técnica en el año 2018.

El proceso de aplicación del instrumento se llevó a cabo a través de tres momentos: un primer momento en el que se aplicó la escala como PreTest durante el proceso de inducción de los estudiantes. El objetivo de esta primera aplicación era determinar el grado de competencias digitales (prerrequisitos para su programa formativo) con el que los estudiantes ingresaban al programa. Un segundo momento como PostTest, cuyo objetivo era determinar la incidencia de una estrategia de intervención de aula mediada por ambientes virtuales de aprendizaje que se implementó durante tres meses con los estudiantes para fortalecer las competencias que se identificaron con falencias durante el PreTest; y finalmente, un tercer momento en el que se realizó un análisis estadístico comparativo de los resultados de los momentos 1 y 2.

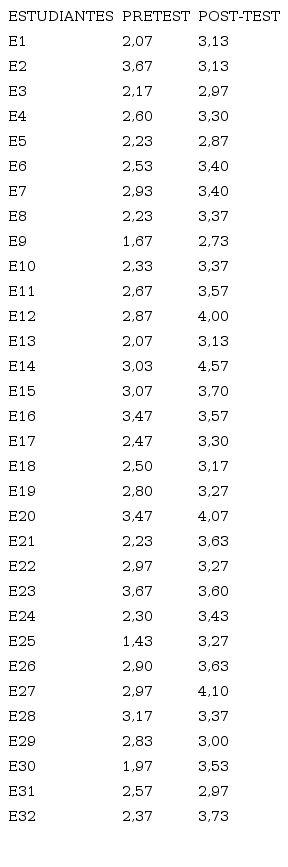

La Tabla 11 muestra los resultados generales de PreTest y PostTest para la muestra de 32 estudiantes:

Tabla 11.

Resultados globales aplicación instrumento

Fuente: elaboración propia.

Fuente: elaboración propia.

|

ESTUDIANTES

|

PRETEST

|

POST-TEST

|

|

E1

|

2,07

|

3,13

|

|

E2

|

3,67

|

3,13

|

|

E3

|

2,17

|

2,97

|

|

E4

|

2,60

|

3,30

|

|

E5

|

2,23

|

2,87

|

|

E6

|

2,53

|

3,40

|

|

E7

|

2,93

|

3,40

|

|

E8

|

2,23

|

3,37

|

|

E9

|

1,67

|

2,73

|

|

E10

|

2,33

|

3,37

|

|

E11

|

2,67

|

3,57

|

|

E12

|

2,87

|

4,00

|

|

E13

|

2,07

|

3,13

|

|

E14

|

3,03

|

4,57

|

|

E15

|

3,07

|

3,70

|

|

E16

|

3,47

|

3,57

|

|

E17

|

2,47

|

3,30

|

|

E18

|

2,50

|

3,17

|

|

E19

|

2,80

|

3,27

|

|

E20

|

3,47

|

4,07

|

|

E21

|

2,23

|

3,63

|

|

E22

|

2,97

|

3,27

|

|

E23

|

3,67

|

3,60

|

|

E24

|

2,30

|

3,43

|

|

E25

|

1,43

|

3,27

|

|

E26

|

2,90

|

3,63

|

|

E27

|

2,97

|

4,10

|

|

E28

|

3,17

|

3,37

|

|

E29

|

2,83

|

3,00

|

|

E30

|

1,97

|

3,53

|

|

E31

|

2,57

|

2,97

|

|

E32

|

2,37

|

3,73

|

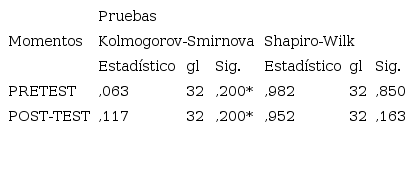

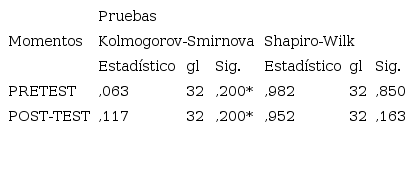

Para realizar el análisis estadístico, el primer paso era determinar el principio de normalidad para los resultados del Pretest y del PostTest. Lo anterior, para determinar el tipo de prueba estadística más adecuada, teniendo en cuenta que si ambos grupos de datos tienen distribución normal, entonces lo más recomendable es utilizar una prueba estadística paramétrica para muestras relacionadas, de lo contrario (los grupos de datos no presentan distribución normal), se deben utilizar pruebas estadísticas no paramétricas para muestras relacionadas (González, Escoto, & Chávez, 2017).

Para verificar el principio de normalidad se plantearon las siguientes hipótesis: para el PreTest se consideró como hipótesis nula H0: la muestra pre-test proviene de una población con distribución normal; y como hipótesis alternativa Ha: la muestra pre-test no proviene de una población con distribución normal de forma similar se redactaron las hipótesis para el PostTest. Aceptando la hipótesis nula cuando el p-valor resultado de la prueba estadística es mayor a 0.05 (González et al., 2017).

Una vez definidas las hipótesis se cargaron los datos en el software SPSS y se consideraron los siguientes criterios para seleccionar el tipo de prueba estadística que aplicaba para el tamaño de muestra en cuestión. Así, se tomarían en cuenta los resultados del estadístico Kolmogorov-Smirnov para muestras grandes (>30 individuos) y para los resultados del estadístico Shapiro-Wilk para muestras pequeñas (< 30 individuos) (González et al., 2017). Los resultados de la prueba de normalidad se muestran en la Tabla 12.

Tabla 12.

Prueba de normalidad PreTest y PostTest

Fuente: resultados software SPSS.

Fuente: resultados software SPSS.

|

Momentos

|

Pruebas

|

|

Kolmogorov-Smirnova

|

Shapiro-Wilk

|

|

Estadístico

|

gl

|

Sig.

|

Estadístico

|

gl

|

Sig.

|

|

PRETEST

|

,063

|

32

|

,200*

|

,982

|

32

|

,850

|

|

POST-TEST

|

,117

|

32

|

,200*

|

,952

|

32

|

,163

|

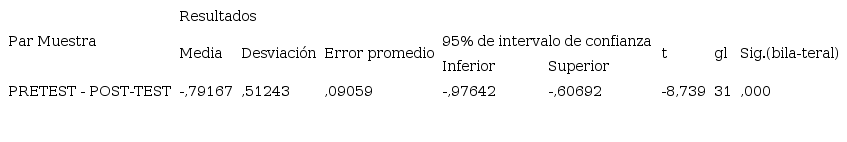

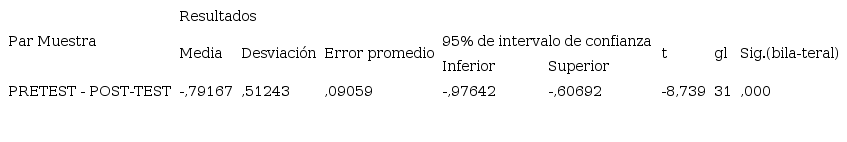

Dado que tanto en el PreTest como en el PostTest el p-valor (Sig.) es >= 0.05, se puede concluir que ambas muestras provienen de población con distribución normal, por lo tanto, se puede realizar una comparación de muestras paramétrica a través de una prueba T-Studend (González et al., 2017), para la cual se tuvo en cuenta como hipótesis nula H0: No hay diferencia significativa en el nivel de competencias digitales de los estudiantes de media técnica antes y después de la estrategia de intervención, y como hipótesis alterna Ha: Hay diferencia significativa en el nivel de competencias digitales de los estudiantes de media técnica antes y después de la estrategia de intervención. Rechazando la hipótesis nula cuando el p-valor resultado de la prueba es menor o igual a 0.05. La Tabla 13 muestra los resultados de la aplicación de la prueba T-Student.

Tabla 13.

Resultados prueba T-Student

Fuente: resultados software SPSS.

Fuente: resultados software SPSS.

|

Par Muestra

|

Resultados

|

|

Media

|

Desviación

|

Error promedio

|

95% de intervalo de confianza

|

t

|

gl

|

Sig.(bila-teral)

|

|

Inferior

|

Superior

|

|

PRETEST - POST-TEST

|

-,79167

|

,51243

|

,09059

|

-,97642

|

-,60692

|

-8,739

|

31

|

,000

|

Dado que P-valor=0.000, se rechaza H0 y se acepta Ha: Hay diferencia significativa en el nivel de competencias digitales de los estudiantes de media técnica antes y después de la estrategia de intervención. Por lo cual, se concluye que la estrategia e intervención de aula, bajo el enfoque de secuencias didácticas y mediadas por ambientes virtuales de aprendizaje insidió positivamente en el desarrollo de competencias digitales en los estudiantes de media técnica. De hecho, los estudiantes en promedio mejoraron su valoración de competencias digitales de 2.43 a 3.42, en un periodo aproximado de 3 meses.

CONCLUSIONES

A través del proceso de validación de la escala de Valoración de Competencias Digitales (EVCD), se pudo verificar los criterios psicométricos de validez y fiabilidad, lo cual arrojó como resultado un nuevo instrumento de medición pertinente para el contexto colombiano. El nuevo instrumento tiene seis dimensiones y 30 reactivos.

La fase de validez de contenido a través del juicio de expertos permitió realizar los ajustes en cuanto a terminología y nivel de lenguaje adecuado para el contexto específico de aplicación mediante la validación de los criterios de suficiencia, claridad, coherencia y relevancia, soportados en los cálculos de los diferentes índices de validación de contenido.

La fase de validación de constructo permitió por medio de los análisis factoriales, exploratorio y confirmatorio obtener una reducción de dimensiones y una nueva agrupación de ítem en torno a las mismas, así como la verificación del ajuste del modelo a los datos empíricos.

La fase de análisis de fiabilidad arrojó una fiabilidad alta que permite concluir que los resultados fruto de la aplicación del instrumento serán consistentes independientemente que cambie la población de estudio.

La aplicación del instrumento ya validado en una muestra específica permitió medir las competencias digitales de manera más precisa y confiable, con lo cual es posible evaluar de manera veraz el impacto de una estrategia de intervención de aula orientada al desarrollo de competencias digitales.

El nuevo instrumento validado podrá usarse dentro del contexto colombiano para realizar procesos de diagnóstico de competencias digitales, orientados a identificar las dimensiones con falencias en una población específica, para planear estrategias formativas pertinentes y contextualizadas. De igual manera, el instrumento puede ser utilizado por la comunidad académica colombiana en procesos de investigación que involucren competencias digitales, ya que reduciría los tiempos de investigación y permitiría que los investigadores se concentren en el análisis e interpretación de los resultados.

Como una recomendación en el uso del instrumento presentado en este artículo, se sugiere que la aplicación se realice con acompañamiento y supervisión, con el fin de resolver las dudas que se generen en la población objeto de aplicación; reducir el error humano asociado; y contextualizar los individuos en cuanto a las dimensiones conceptuales que se pretenden analizar.

Es importante establecer que el nuevo instrumento validado tiene sus fundamentos en competencias digitales genéricas definidas en el Marco Común Europeo para competencias digitales, sin embargo, cabe aclarar que el proceso de validación ejecutado para la presente investigación se realizó priorizando aquellas dimensiones de las competencias digitales pertinentes para las necesidades específicas del contexto colombiano en el momento de ejecución del trabajo investigativo. En este sentido y considerando los vertiginosos cambios de la actual sociedad de la información y el conocimiento, es posible que el instrumento pierda vigencia y/o pertinencia, por lo que su aplicación en otras investigaciones debe evaluarse teniendo en cuenta las variables espacio temporales específicas para cada caso.

REFERENCIAS

Aráuz, A. F. (2015). Aplicación del análisis factorial confirmatorio a un modelo de medición del rendimiento académico en lectura. Ciencias Económicas, 33, 39–66.

Arias, B. (2008). Desarrollo de un ejemplo de análisis factorial confirmatorio con LISREL, AMOS y SAS. Presentado en Seminario de Actualización en Investigación sobre Discapacidad SAID, 2008. España: Universidad de Valladolid.

Association of College and Research Libraries. (2000). Information Literacy Competency Standards in Higher Education. ACRL. Recuperado de https://alair.ala.org/handle/11213/7668

Cruzate, J. M., & Graells, P. M. (2001). La revolución educativa en la era de Internet (1a Ed.). España: Wolters Kluwer Educación.

ECDL Foundation. (1997). European Computer Driving Licence. Recuperado de http://ecdl.org/

Ferrari, A. (2013). DIGCOMP: A Framework for Developing and Understanding Digital Competence in Europe (Scientific and Policy Report). European Commission Joint Research, Centre Institute for Prospective, Technological Studies. Recuperado de http://ftp.jrc.es/EURdoc/JRC83167.pdf

Ferreiro, A. A. (2011). El desarrollo del concepto de competencia digital en el currículum de las enseñanzas obligatorias de Galicia. Innovación Educativa, 21, 151–159.

Frías, D. (2014). Apuntes de SPSS. Universidad de Valencia. Recuperado de https://www.uv.es/friasnav/ApuntesSPSS.pdf

George, D., & Mallery, P. (2003). SPSS for Windows step by step: A simple guide and reference (4a ed.). Boston: Allyn & Bacon.

Gobierno Vasco. (2015). IKANOS (Versión 6). España. Recuperado de http://www.innova.euskadi.eus/informacion/el-proyecto-digcomp/v62-ikanoscd/es/

González, F., Escoto, M., & Chávez, J. (2017). Estadística aplicada en psicología y ciencias de la salud (1a ed.). Mexico: Manual Moderno.

Hair, J., Anderson, R., Tatham, R., & Black, W. (1999). Análisis multivariante (5a Ed.). Madrid: Prentice Hall Iberia.

IBM. (2017). IBM SPSS Statistics (Versión 25). Armonk, Nueva York: International Business Machines Corporation.

Ihaka, R., & Gentleman, R. (2018). The R Project for Statistical Computing (Versión 3.4.4). Recuperado de https://www.r-project.org/

Junta de Andalucía. (2010). Digcomp: Herramienta de autodiagnóstico en competencias digitales. España. Recuperado de http://www.digcomp.andaluciaesdigital.es/

Lawshe, C. (1975). A quantitative approach to content validity. Personnel Psychology, 28(4), 563–575.

Méndez, C., & Rondón, M. (2012). Introducción al análisis factorial exploratorio. Revista Colombiana de Psiquiatría, 41, 197–207.

Ministerio de las TIC. (2017). Ciudadanía Digital. Colombia.Recuperado de https://www.ciudadaniadigital.gov.co

Nieto, R. H. (2002). Contributions to Statistical Analysis. Venezuela: Universidad de los Andes.

Pech, S. J., & Prieto, M. E. (2015). La medición de la competencia digital e informacional. en Desarrollo de las competencias para el Siglo 21. Recuperado de https://www.researchgate.net/publication/303075873_La_medicion_de_la_Competencia_Digital_e_Informacional

Pedrosa, I., Álvarez, J. S., & Cueto, E. G. (2014). Evidencias sobre la validez de contenido: avances teóricos y métodos para su estimación. Acción Psicológica, 10(2), 3–20.

Pérez, J. E., & Martínez, Á. C. (2008). Validez de contenido y juicio de expertos: una aproximación a su utilización. Avances en Medición, 6(1), 27–36.

Rodríguez, A. M. S. (2014). Diseño y validación de instrumentos de medición. Diálogos, 8(13), 19–40.

Sallan, J., Fernández, V., Simo, P., Lordan, O., & González, D. (2012). Análisis de modelos de ecuaciones estructurales mediante el paquete Lavaan. Presentado en 6th International Conference on Industrial Engineering and Industrial Management. XVI Congreso de Ingeniería de Organización. España: Universitat Politécnica de Catalunya.

Sampieri, R. H., Collado, C. F., & Lucio, M. del P. B. (2014). Metodología de la investigación (Sexta Edición). McGraw-HILL.

Université de Limoges. (2000). Certificat Informatique et Internet. Limoges, France. Recuperado de http://c2i.unilim.fr/

Villamil, P. C. G. (2012). Estado del arte de la conceptualización sobre competencias digitales en educación formal en América Latina (Trabajo de grado). Pontificia Bogotá: Universidad Javeriana. Recuperado de https://repository.javeriana.edu.co/handle/10554/7937

Información adicional

Este artículo se escribe dentro del marco del trabajo de grado: Validación y aplicación de una escala de valoración de competencias digitales para analizar la incidencia de una intervención de aula mediada por ambientes virtuales de aprendizaje. El cual se presenta para optar por el título de Magister en Ciencias: Innovaciones en Educación del Instituto Tecnológico Metropolitano (ITM). Medellín-Colombia.

Enlace alternativo

https://revistas.itm.edu.co/index.php/trilogia/article/view/1083/1181 (pdf)